Linux下配置Hadoop伪分布式环境

一、环境资源

JDK和Hadoop存在版本兼容问题,选择安装包的时候一定要考虑到两个软件的版本兼容,我这里选择的安装版本如下:

- JDK1.8:https://pan.baidu.com/s/1Rm5ErmvKFjVmwx1uAF90vQ 提取码:kpre

- Hadoop2.7:https://pan.baidu.com/s/1xynMsryyTDZBn\_ApgbuTSA 提取码:ir1l

二、安装JDK

- 将Java安装文件上传到服务器上。

将安装文件解压缩,并记录jdk解压文件根目录

tar -zxvf 文件名 解压目录 //解压到当前目录时,可以省略解压目录

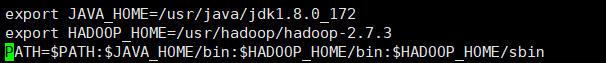

配置JDK环境变量,打开配置文件,在文件末尾加入JDK配置,配置内容如截图所示

vi /etc/profile

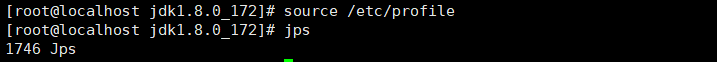

刷新环境变量:输入命令,之间刷新

source /etc/profile

输入 jps 命令,如果出现jdk进程信息,说明JDK环境配置成功

三、安装SSH免密

默认情况下,使用ssh登陆Linux,都需要提供秘钥,登陆本机也是需要秘钥,因此启动Hadoop时,也是需要输入秘钥信息,为避免每次启动都输入秘钥,可以通过下面的命令,实现本机登陆时免秘钥。

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa //生成秘钥文件cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys //安装秘钥

四、安装配置Hadoop

- 将Hadoop安装文件上传到服务器上

将Hadoop安装文件解压,并记录下Hadoop的根目录

tar -zxvf 文件名 解压目录 //解压到当前目录时,可以省略解压目录

配置Hadoop环境变量,在/etc/profile末尾加上对应的配置信息

vi /etc/profile

配置Hadoop的Java环境变量:需要为Hadoop根目录下,ect/hadoop/下的hadoop-env.sh、mapred-env.sh、yarn-env.sh三个文件分别设置Java环境变量,将JAVA_HOME设置为我们安装的Java根目录

vi hadoop-env.sh

vi mapred-env.sh

vi yarn-env.sh

配置core-site.xml,文件同样在Hadoop根目录下的ect/hadoop/目录中,需要在文件中,加入如下配置

vi core-site.xml

fs.defaultFS

hdfs://你的IP:9000

hadoop.tmp.dir

你的Hadoop环境存储位置

配置hdfs-site.xml,文件同样在Hadoop根目录下的ect/hadoop/目录中

vi hdfs-site.xml

dfs.replication

1

dfs.namenode.secondary.http-address

你的IP:50090

配置slaves文件:将文件中的localhost替换为你的IP

vi slaves

格式化hdfs:每个Hadoop只需在第一次进行格式化,以后直接启动即可,出现successfully表示格式化成功。

hdfs namenode -format

启动集群:启动后,可以输入 jps 命令,查看Java进程(Hadoop进程都是Java进程),出现进程,代表启动成功。

start-dfs.sh

- 访问Hadoop:访问地址是 你的IP:50070,出现这个页面,代表整个配置完成,如果出错,Hadoop会在根目录的log目录下生产日志文件,可以根据日志,调整配置。

关闭防火墙

如果不能访问,请确认是否关闭了防火墙,关闭命令:

systemctl stop firewalld.service //停止firewall

systemctl disable firewalld.service //禁止firewall开机启动

还没有评论,来说两句吧...