网络爬虫实践:解析HTML标签遇到的问题

在实际的网络爬虫实践中,解析HTML标签可能会遇到以下问题:

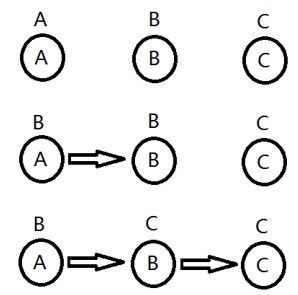

标签结构复杂:有些网站的HTML结构非常复杂,嵌套多层标签,这会给爬虫的解析带来困难。

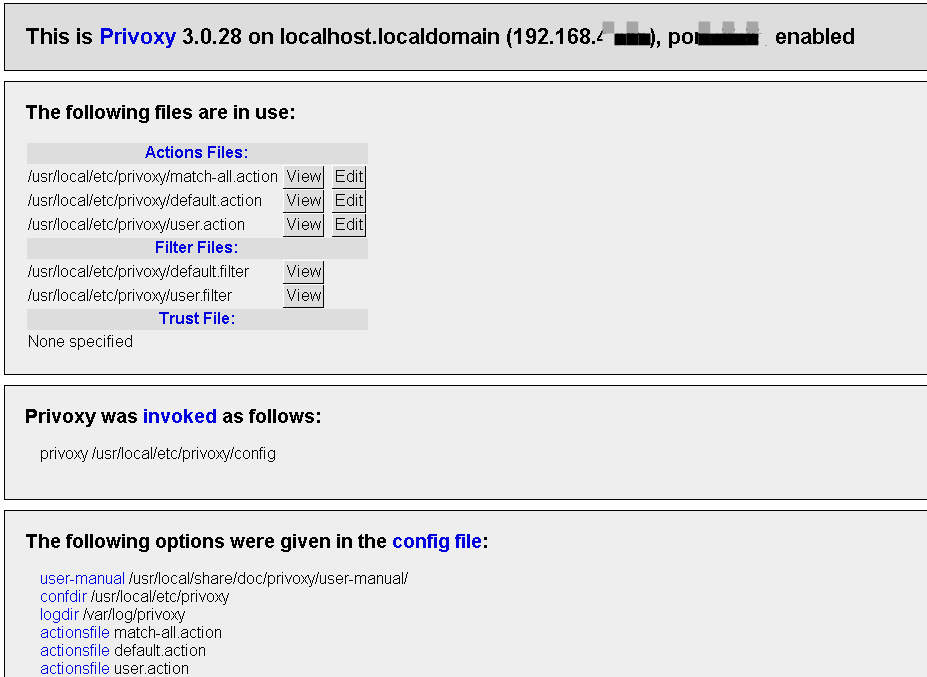

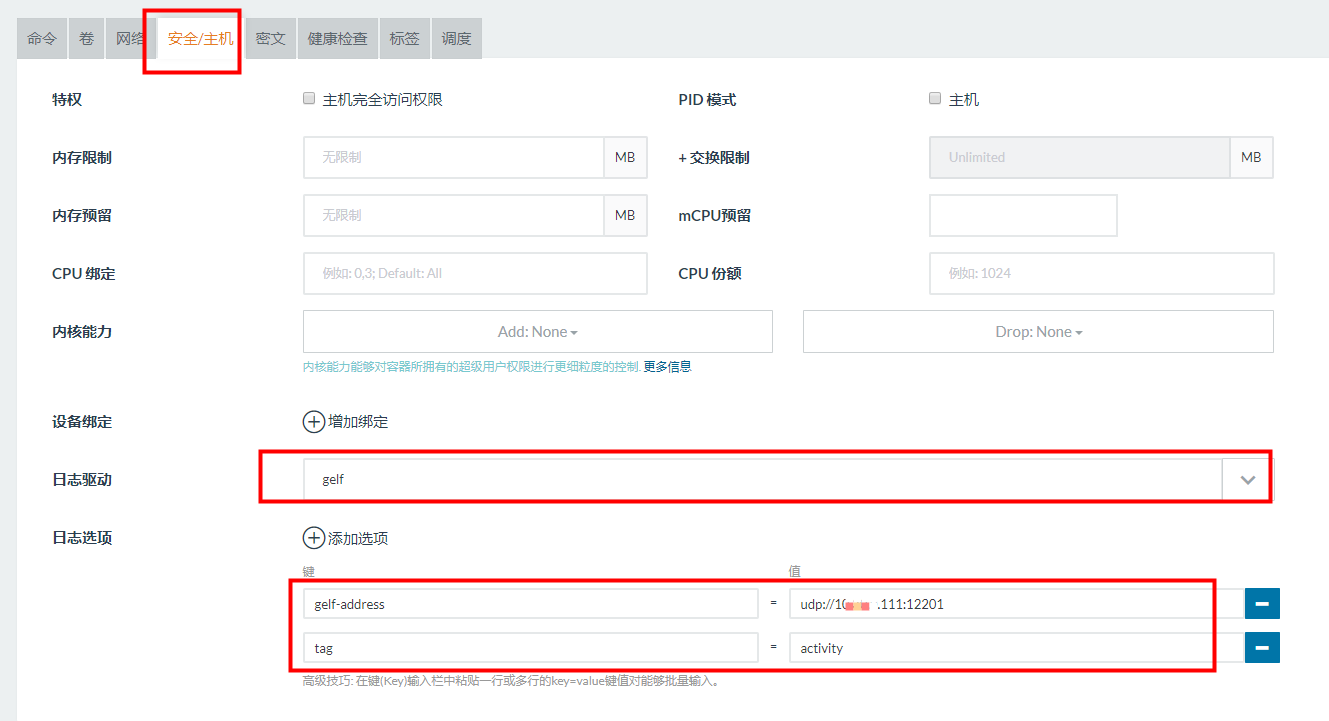

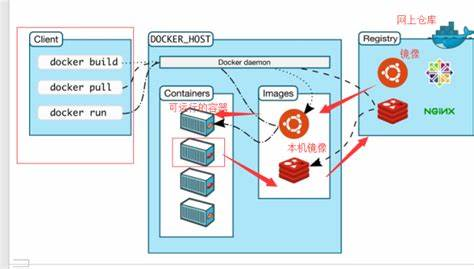

缓存和反爬机制:部分网站会使用缓存技术,对页面进行存储,下次访问时直接返回缓存内容。此外,一些网站还通过各种手段防止爬虫抓取数据,例如JavaScript生成的内容、IP限制等。

HTML标签不标准:有些网站在编写HTML代码时可能不够规范,导致某些标签被错误地解析或丢失。

字符编码问题:不同的网站可能会使用不同的字符编码,如果爬虫没有正确处理这个问题,可能会导致解析失败或者乱码现象。

还没有评论,来说两句吧...