hadoop_安装_伪集群

- 装一台新虚拟机

1) 机器准备

安装centos7

ip:192.168.75.108;

密码:root123;

2) 修改hosts

Vi /etc/hosts

192.168.75.108 centos8

3) 关闭访火墙

#查看firewall

systemctl status firewalld.service

#启动firewall

systemctl start firewalld.service

#停止firewall

systemctl stop firewalld.service

#禁止firewall开机启动

systemctl disable firewalld.service

4) 修改主机名

hostnamectl set-hostname centos8

- 无密码访问

ssh-keygen

ssh-copy-id root@centos8

- 装jdk

安装命令:

rpm -ivh jdk-8u11-linux-x64.rpm

环境变量如下:

vi /etc/profile

export JAVA_HOME=/usr/java/jdk1.8.0_11

export PATH=$PATH:$JAVA_HOME/bin

source /etc/profile

- 装hadoop

1) 准备安装包

创建目录/opt/hadoop,将包放进去:

解压:

tar -zxvf hadoop-2.6.0.tar.gz

2) 修改环境变量

vi /etc/profile

export HADOOP_HOME=/opt/hadoop/hadoop-2.6.0

export PATH=.:$HADOOP_HOME/bin::$HADOOP_HOME/sbin:$PATH

source /etc/profile

验证:hadoop version

3) 修改配置文件

① hadoop-env.sh

vi $HADOOP_HOME/etc/hadoop/hadoop-env.sh

在文件中修改JAVA_HOME参数

export JAVA_HOME=/usr/java/jdk1.8.0_11

② hdfs-site.xml

vi $HADOOP_HOME/etc/hadoop/hdfs-site.xml

③ core-site.xml

vi $HADOOP_HOME/etc/hadoop/core-site.xml

在

19000为rpc的端口号,默认为9000

④ mapred-site.xml

vi $HADOOP_HOME/etc/hadoop/mapred-site.xml

在

注:上面的包中并没有mapred-site.xml文件,只有mapred-site.xml.template文件。

其内容就是它,拷贝一份再改。

cp mapred-site.xml.template mapred-site.xml

⑤ yarn-site.xml

vi $HADOOP_HOME/etc/hadoop/yarn-site.xml

在

4) 格式化hdfs

① 创建配置文件中指定的各目录:

l core-site.xml的hadoop.tmp.dir目录

cd /opt/hadoop/

mkdir hadoop_tmp

mkdir dfs dfs/data dfs/name

② 格式化hdfs

hdfs namenode -format

- 启动hadoop

start-all.sh

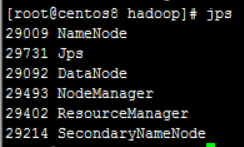

- 检查启动结果

Jps查看进程,有五个:

还没有评论,来说两句吧...