node总结之Stream(流)了解下

简单来说 Stream 是一个抽象接口,Node 中有很多对象实现了这个接口。例如,对http 服务器发起请求的request 对象就是一个 Stream,还有stdout(标准输出)。在Node中有四种流类型:

- Readable - 可读操作。

- Writable - 可写操作。

- Duplex - 可读可写操作.

- Transform - 操作被写入数据,然后读出结果。

基本上所有的 Stream 对象都是 EventEmitter 的实例,常用的事件如下:

- data - 当有数据可读时触发。

- end - 没有更多的数据可读时触发。

- error - 在接收和写入过程中发生错误时触发。

- finish - 所有数据已被写入到底层系统时触发。

我们先来创建 input.txt 文件,做测试用,如下:

luyaran is my lover

完事创建 main.js 文件, 代码如下:

var fs = require("fs");var data = '';// 创建可读流var readerStream = fs.createReadStream('input.txt');// 设置编码为 utf8。readerStream.setEncoding('UTF8');// 处理流事件 --> data, end, and errorreaderStream.on('data', function(chunk) {data += chunk;});readerStream.on('end',function(){console.log(data);});readerStream.on('error', function(err){console.log(err.stack);});console.log("程序执行完毕");

再来看如何写入:

var fs = require("fs");var data = 'luyaran';// 创建一个可以写入的流,写入到文件 output.txt 中var writerStream = fs.createWriteStream('output.txt');// 使用 utf8 编码写入数据writerStream.write(data,'UTF8');// 标记文件末尾writerStream.end();// 处理流事件 --> data, end, and errorwriterStream.on('finish', function() {console.log("写入完成。");});writerStream.on('error', function(err){console.log(err.stack);});console.log("程序执行完毕");

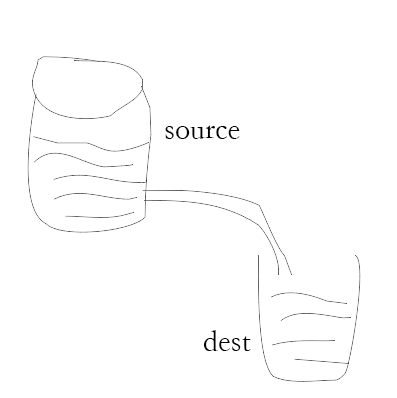

管道提供了一个输出流到输入流的机制,通常我们用于从一个流中获取数据并将数据传递到另外一个流中,来看下流程图:

如上面的图片所示,我们把文件比作装水的桶,而水就是文件里的内容,我们用一根管子(pipe)连接两个桶使得水从一个桶流入另一个桶,这样就慢慢的实现了大文件的复制过程。

来看实例:

var fs = require("fs");// 创建一个可读流var readerStream = fs.createReadStream('input.txt');// 创建一个可写流var writerStream = fs.createWriteStream('output.txt');// 管道读写操作// 读取 input.txt 文件内容,并将内容写入到 output.txt 文件中readerStream.pipe(writerStream);console.log("程序执行完毕");

链式是通过连接输出流到另外一个流并创建多个流操作链的机制,一般用于管道操作。

接下来我们就是用管道和链式来压缩和解压文件,代码如下:

var fs = require("fs");var zlib = require('zlib');// 压缩 input.txt 文件为 input.txt.gzfs.createReadStream('input.txt').pipe(zlib.createGzip()).pipe(fs.createWriteStream('input.txt.gz'));console.log("文件压缩完成。");

执行完以上操作后,我们可以看到当前目录下生成了 input.txt 的压缩文件 input.txt.gz。接下来,让我们来解压该文件,创建 decompress.js 文件,代码如下:

var fs = require("fs");var zlib = require('zlib');// 解压 input.txt.gz 文件为 input.txtfs.createReadStream('input.txt.gz').pipe(zlib.createGunzip()).pipe(fs.createWriteStream('input.txt'));console.log("文件解压完成。");

现在嘞,又有了这么一个需求,就是把input里面的内容写到outInput里面去,但是上面的方法都是把文档里面的内容重置了,需求只想添加,而且保留原内容怎么办呢,我们可以在可读流创建完毕的回调函数里面进行操作,如下:

let fs = require('fs');let data = '';let data2 = '你的小青蛙是真的可爱';//1.读取流//创建可读流let readStream = fs.createReadStream("input.txt");//设置utf-8编码readStream.setEncoding('UTF8');//处理流事件readStream.on('data', chunk => data += chunk);readStream.on('end', () => writeS(data));readStream.on("error", err => console.log(err.strck));console.log("程序1执行完毕");//2.写入流//创建可写流let writeS = dataS =>{let writeStream = fs.createWriteStream("outInput.txt");//使用utf-8写入流writeStream.write(data2+dataS, "UTF8");//标记文件末尾writeStream.end();//处理事件流writeStream.on("finish", () => console.log("写入完成"));writeStream.on("error", err => console.log(err.stack));console.log("程序2执行完毕");}

我们还可以设置写入流的追加参数来解决:

var fs = require('fs');var read = fs.createReadStream('../data/input.txt');//设置第二个参数appendvar write = fs.createWriteStream('../data/out.txt', { 'flags': 'a' });//管道流读写操作read.pipe(write);console.log('执行完毕');

再来就是中文乱码问题了,咱们可以全局安装 iconv-lite 这个模块:

npm install -g iconv-lite

代码样式如下:

var iconv = require('iconv-lite');var fs = require('fs');var fileStr = fs.readFileSync('D:\\test.csv', {encoding:'binary'});var buf = new Buffer(fileStr, 'binary');var str = iconv.decode(buf, 'GBK');console.log(str);

原理很简单,就是先统一用二进制编码方式读取,然后再用 GBK 解码。

好啦,本次记录就到这里了。

如果感觉不错的话,请多多点赞支持哦。。。

![[算法]放苹果问题 [算法]放苹果问题](https://image.dandelioncloud.cn/images/20220523/3161a5119cb74f4c923ee157c43905a7.png)

还没有评论,来说两句吧...