使用Log-Pilot + logstash+Elasticsearch + Kibana 收集 kubernetes 日志

开发者在面对 Kubernetes 分布式集群下的日志需求时,常常会感到头疼,既有容器自身特性的原因,也有现有日志采集工具的桎梏,主要包括:

容器本身特性:

采集目标多:容器本身的特性导致采集目标多,需要采集容器内日志、容器 stdout。对于容器内部的文件日志采集,现在并没有一个很好的工具能够去动态发现采集。针对每种数据源都有对应的采集软件,但缺乏一站式的工具。

弹性伸缩难*:Kubernetes 是分布式的集群,服务、环境的弹性伸缩对于日志采集带来了很大的困难,无法像传统虚拟机环境下那样,事先配置好日志的采集路径等信息,采集的动态性以及数据完整性是非常大的挑战。

现有日志工具的一些缺陷

缺乏动态配置的能力。目前的采集工具都需要事先手动配置好日志采集方式和路径等信息,因为它无法能够自动感知到容器的生命周期变化或者动态漂移,所以它无法动态地去配置。

日志采集重复或丢失的问题。因为现在的一些采集工具基本上是通过 tail 的方式来进行日志采集的,那么这里就可能存在两个方面的问题:一个是可能导致日志丢失,比如采集工具在重启的过程中,而应用依然在写日志,那么就有可能导致这个窗口期的日志丢失;而对于这种情况一般保守的做法就是,默认往前多采集 1M 日志或 2M 的日志,那么这就又会可能引起日志采集重复的问题。

未明确标记日志源。因为一个应用可能有很多个容器,输出的应用日志也是一样的,那么当我们将所有应用日志收集到统一日志存储后端时,在搜索日志的时候,我们就无法明确这条日志具体是哪一个节点上的哪一个应用容器产生的。

本文档将介绍一种 Docker 日志收集工具 Log-Pilot,结合 Elasticsearch 和 Kibana、logstash 等工具,形成一套适用于 Kubernetes 环境下的一站式日志解决方案。

Log-Pilot 介绍

log-Pilot 是一个智能容器日志采集工具,它不仅能够高效便捷地将容器日志采集输出到多种存储日志后端,同时还能够动态地发现和采集容器内部的日志文件。

针对前面提出的日志采集难题,Log-Pilot 通过声明式配置实现强大的容器事件管理,可同时获取容器标准输出和内部文件日志,解决了动态伸缩问题,此外,Log-Pilot 具有自动发现机制,CheckPoint 及句柄保持的机制,自动日志数据打标,有效应对动态配置、日志重复和丢失以及日志源标记等问题。

目前 log-pilot 在 Github 完全开源,项目地址是 https://github.com/AliyunContainerService/log-pilot 。您可以深入了解更多实现原理。

针对容器日志的声明式配置

Log-Pilot 支持容器事件管理,它能够动态地监听容器的事件变化,然后依据容器的标签来进行解析,生成日志采集配置文件,然后交由采集插件来进行日志采集。

在 Kubernetes 下,Log-Pilot 可以依据环境变量 aliyun_logs_$name = $path 动态地生成日志采集配置文件,其中包含两个变量:

$name 是我们自定义的一个字符串,它在不同的场景下指代不同的含义,在本场景中,将日志采集到 ElasticSearch 的时候,这个 $name 表示的是 Index。

另一个是 KaTeX parse error: Expected group after ‘_‘ at position 420: …,通过 aliyun_logs_̲name_format= 标签就可以告诉 Log-Pilot 在采集日志的时候,同时以什么样的格式来解析日志记录,支持的格式包括:none、json、csv、nginx、apache2 和 regxp。

Log-Pilot 同时支持自定义 tag,我们可以在环境变量里配置 aliyun_logs_$name_tags=“K1=V1,K2=V2”,那么在采集日志的时候也会将 K1=V1 和 K2=V2 采集到容器的日志输出中。自定义 tag 可帮助您给日志产生的环境打上 tag,方便进行日志统计、日志路由和日志过滤。

实战部分

架构:log-polit —> logstash —> es —> kibana

准备工作

1.k8s 集群 搭建。(略)

2.logstash 环境搭建。(略)

3.es集群(略)

4.kibana 展示端(略)

已上准备工作不是本篇文章的重点,不做论述。

log-pilot 以pod 的形式部署在k8s上

cat log-pilot-DaemonSet.yamlapiVersion: extensions/v1beta1kind: DaemonSetmetadata:name: log-pilotlabels:app: log-pilot# 设置期望部署的namespacenamespace: kube-systemspec:updateStrategy:type: RollingUpdatetemplate:metadata:labels:app: log-pilotannotations:scheduler.alpha.kubernetes.io/critical-pod: ''spec:# 是否允许部署到Master节点上tolerations:- key: node-role.kubernetes.io/mastereffect: NoSchedulecontainers:- name: log-pilot# 版本请参考https://github.com/AliyunContainerService/log-pilot/releasesimage: registry.cn-hangzhou.aliyuncs.com/acs/log-pilot:0.9.6-filebeatresources:limits:memory: 500Mirequests:cpu: 200mmemory: 200Mienv:- name: "NODE_NAME"valueFrom:fieldRef:fieldPath: spec.nodeName- name: "LOGGING_OUTPUT"value: "logstash"# 请确保集群到ES网络可达- name: "LOGSTASH_HOST"value: "192.168.6.48"- name: "LOGSTASH_PORT"value: "5044"- name: "LOGSTASH_LOADBALANCE"value: "true"volumeMounts:- name: sockmountPath: /var/run/docker.sock- name: rootmountPath: /hostreadOnly: true- name: varlibmountPath: /var/lib/filebeat- name: varlogmountPath: /var/log/filebeat- name: localtimemountPath: /etc/localtimereadOnly: truelivenessProbe:failureThreshold: 3exec:command:- /pilot/healthzinitialDelaySeconds: 10periodSeconds: 10successThreshold: 1timeoutSeconds: 2securityContext:capabilities:add:- SYS_ADMINterminationGracePeriodSeconds: 30volumes:- name: sockhostPath:path: /var/run/docker.sock- name: roothostPath:path: /- name: varlibhostPath:path: /var/lib/filebeattype: DirectoryOrCreate- name: varloghostPath:path: /var/log/filebeattype: DirectoryOrCreate- name: localtimehostPath:path: /etc/localtime

其中

LOGGING_OUTPUT 是使用logstash接收log-pilot接收到的日志

LOGSTASH_HOST logstash服务的ip地址

LOGSTASH_PORT logstash服务的端口

LOGSTASH_LOADBALANCE 是否为logstash开启负载均衡模式

$ kubectl create -f log-pilot-DaemonSet.yaml$ kubectl get pod --namespace=kube-system |grep log-pilotlog-pilot-9kkvs 1/1 Running 0 56mlog-pilot-nspdv 1/1 Running 0 56mlog-pilot-sszk7 1/1 Running 0 56m

进到容器里面可以看到的进程

$ kubectl exec -it log-pilot-nspdv sh -n kube-system/pilot # ps -efPID USER TIME COMMAND1 root 0:03 /pilot/pilot -template /pilot/filebeat.tpl -base /host -log-level debug19 root 0:50 /usr/bin/filebeat -c /etc/filebeat/filebeat.yml3535 root 0:00 sh3551 root 0:00 ps -ef## 自动生成的filebeat yaml文件/pilot # cat /etc/filebeat/filebeat.ymlpath.config: /etc/filebeatpath.logs: /var/log/filebeatpath.data: /var/lib/filebeat/datafilebeat.registry_file: /var/lib/filebeat/registryfilebeat.shutdown_timeout: 0logging.level: infologging.metrics.enabled: falselogging.files.rotateeverybytes: 104857600logging.files.keepfiles: 10logging.files.permissions: 0600setup.template.name: "filebeat"setup.template.pattern: "filebeat-*"filebeat.config:prospectors:enabled: truepath: ${path.config}/prospectors.d/*.ymlreload.enabled: truereload.period: 10soutput.logstash:hosts: ["192.168.6.48:5044"]index: filebeat-%{+yyyy.MM.dd}loadbalance: true

收集日志端准备好了,开始收集业务日志了。

收集业务日志

应用是用springboot 写的 这里启动一个java应用。yaml文件如下:

$ cat deploy.yamlapiVersion: extensions/v1beta1kind: Deploymentmetadata:name: prexx-xx-account-web-profile-aspec:replicas: 1template:metadata:labels:app: prexx-xx-account-web-profile-aprofile: profile-aspec:volumes:- name: "cephfs-fuse"hostPath:path: "/data/WEBLOG"- name: "preproductnfs"hostPath:path: "/home/nfs"containers:- name: prexx-xx-account-web-profile-aimage: harbor.reg/pre_xx/prexx-xx-account-web:32imagePullPolicy: IfNotPresentvolumeMounts:- name: cephfs-fusemountPath: /data/WEBLOG- name: preproductnfsmountPath: /home/nfsresources:limits:memory: 2000Mirequests:memory: 1500Miports:- containerPort: 8080env:- name: app_namevalue: prexx-xx-account-web- name: aliyun_logs_catalinavalue: "stdout"- name: aliyun_logs_catalina_tagsvalue: "logtype=prexx-xx-account-web,env=prexx"- name: aliyun_logs_logstash-htjfvalue: "/data/WEBLOG/prexx-xx-account-web/*/*.log"- name: aliyun_logs_logstash-htjf_tagsvalue: "logtype=prexx-xx-account-web,env=prexx"livenessProbe:failureThreshold: 3exec:command:- /healthzinitialDelaySeconds: 10periodSeconds: 10successThreshold: 1timeoutSeconds: 2

其中

aliyun_logs_logstash-htjf 指向收集日志的路径

aliyun_logs_logstash-htjf_tags 为收集的日志添加tag

启动应用

$ kunerctl create -f deploy.yaml$ kubectl get pod prexx-xx-account-web-profile-a-5bf9c8947f-gbhpgNAME READY STATUS RESTARTS AGEprexx-xx-account-web-profile-a-5bf9c8947f-gbhpg 1/1 Running 0 1m

配置logstash 文件

根据日志打印格式 (和开发要求日志的打印格式尽量一致,方便收集)定义日志过滤模版。

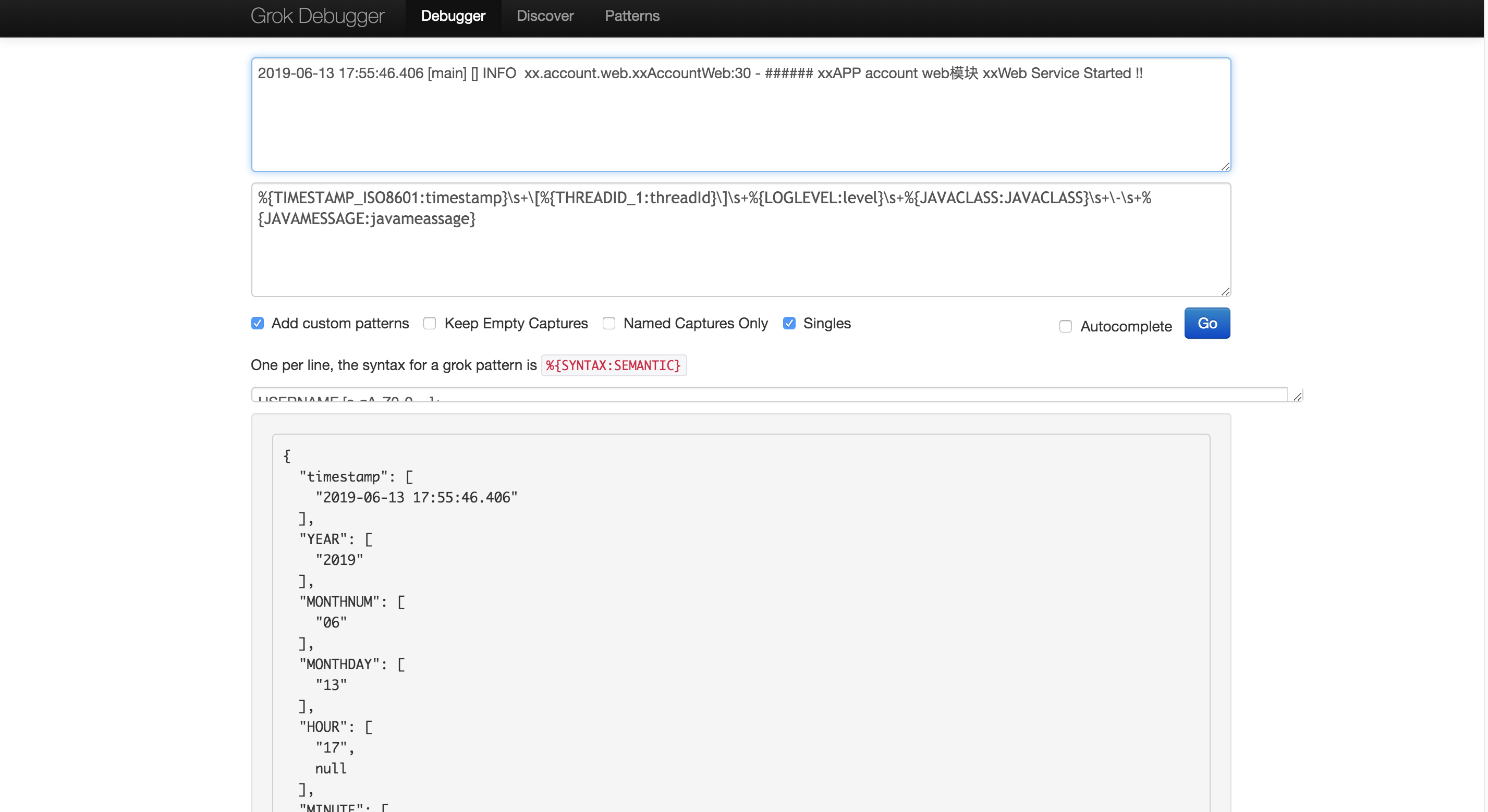

debugger 地址:https://grokdebug.herokuapp.com/ 需要梯子

日志过滤匹配的模版为

%{TIMESTAMP_ISO8601:timestamp}\s+\[%{THREADID_1:threadId}\]\s+%{LOGLEVEL:level}\s+%{JAVACLASS:JAVACLASS}\s+\-\s+%{JAVAMESSAGE:javameassage}

创建logstash文件 接收log-pilot 传过来的日志

cat xx_spring_boot.confinput {beats {port => "5044"codec=> multiline {pattern => "^%{YEAR}.*"negate => truewhat => "previous"}}}filter {grok {patterns_dir => [ "/etc/logstash/patterns.d" ]match => [ "message", "%{TIMESTAMP_ISO8601:timestamp}\s+\[%{THREADID:threadId}\]\s+\[%{THREADNAME:traceId}\]\s+%{LOGLEVEL:level}\s+%{JAVACLASS:javaclass}\s+\-\s+%{JAVAMESSAGE:javameassage}","message", "%{TIMESTAMP_ISO8601:timestamp}\s+\[%{THREADID_1:threadId}\]\s+%{LOGLEVEL:level}\s+%{JAVACLASS:javaclass}\s+\-\s+%{JAVAMESSAGE:javameassage}"]remove_field => [ "message","beat","timestamp","topic","hostname","name"]}date {match => ["time", "dd/MMM/yyyy:HH:mm:ss Z"]locale => "cn"}}output {elasticsearch {hosts => ["192.168.6.17:9200","192.168.6.18:9200","192.168.6.19:9200"]index => "logstash-htjf-filebeat-%{+YYYY-MM}"user => elasticpassword => xx}stdout { codec => rubydebug }}

启动logstash

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/xx_spring_boot.conf --path.data=/var/log/xx_spring_boot.log & > /dev/null

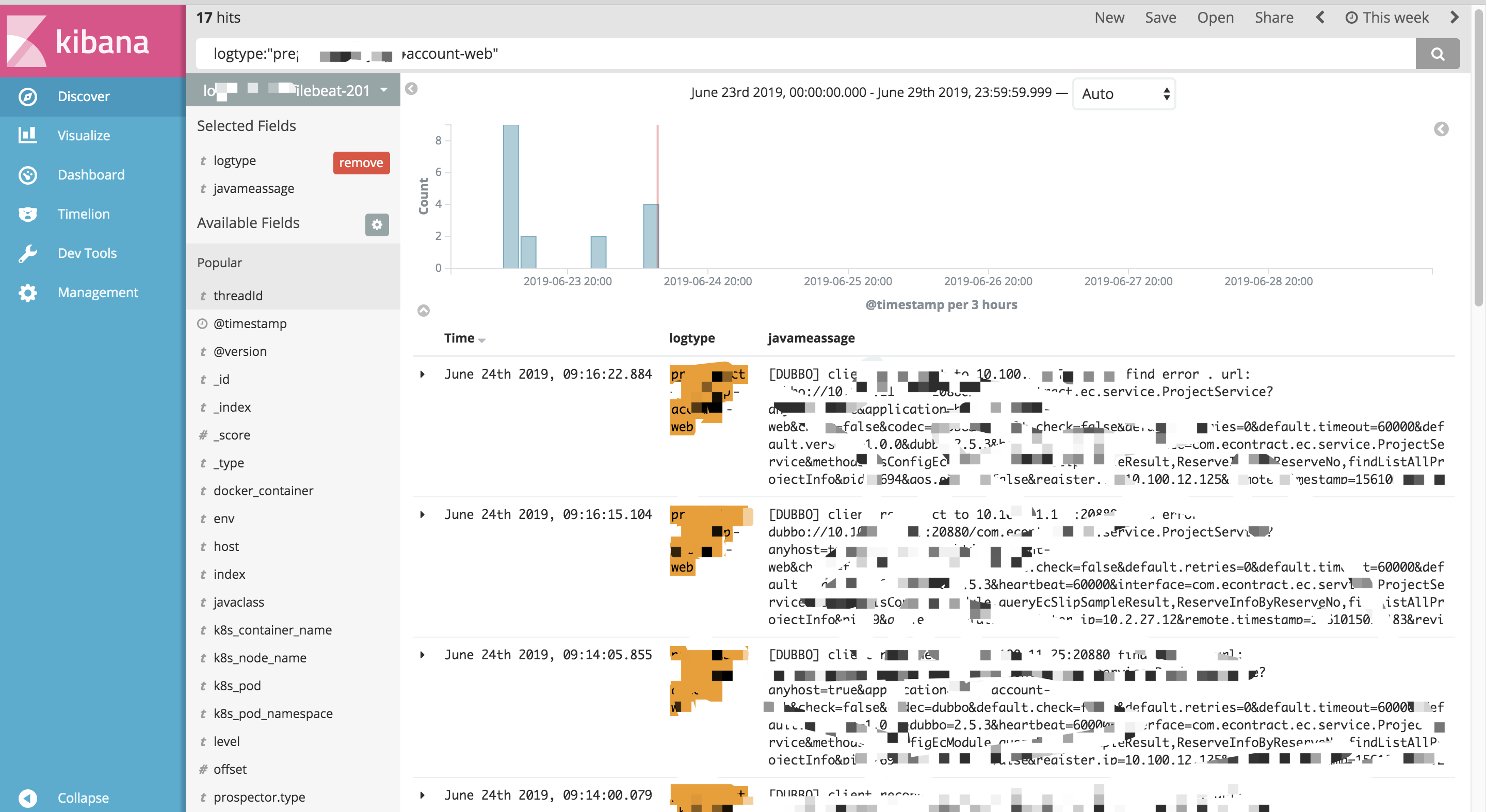

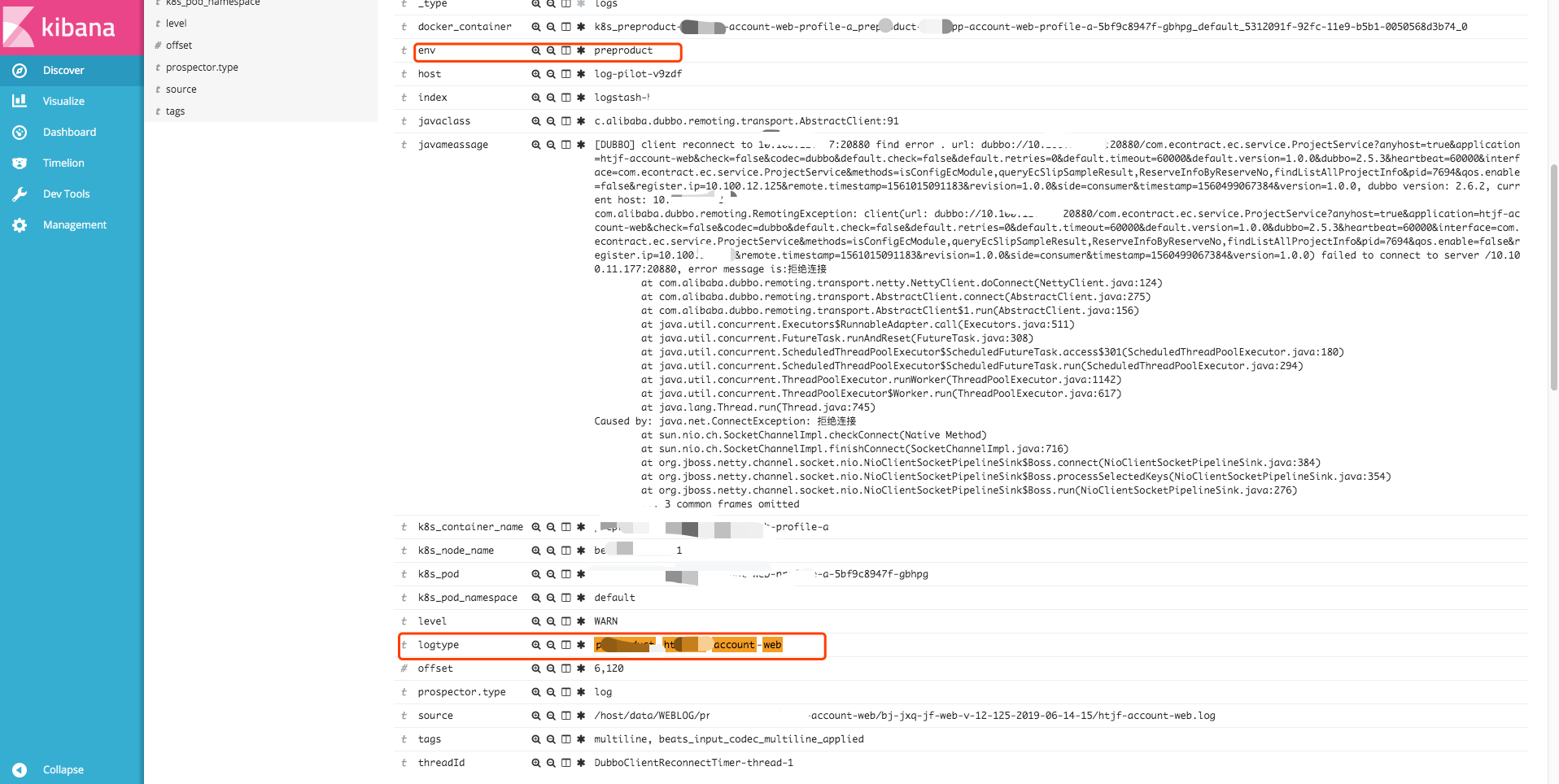

通过kibana 展示收集的日志

通过全局环境变量传进来的tag 也展示出来了。

还没有评论,来说两句吧...