使用Python进行网络爬虫时遇到的常见问题

在网络爬虫中,Python通常会遇到以下几种常见的问题:

访问限制:许多网站有反爬机制,例如IP封禁、验证码验证等。解决方法是使用代理服务器或模拟人类行为来规避。

页面解析错误:当抓取内容的HTML结构发生变化时,原有的解析代码可能无法正确处理。这时需要更新解析库,如BeautifulSoup或PyQuery,或者使用正则表达式进行临时处理。

并发问题:如果爬虫并行抓取数量过多,可能会导致目标网站服务器压力过大,甚至被封IP。此时,可以限制同时发起请求的数量,或者采用异步方式抓取数据。

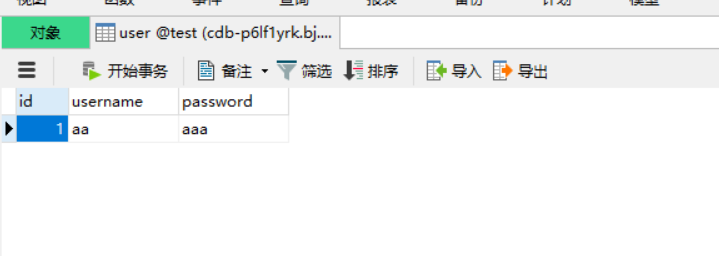

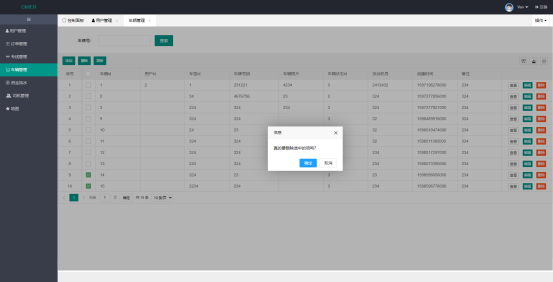

存储和导出问题:抓取的数据如果不进行合理的存储和导出,就无法长期使用。这可能涉及到数据库管理、文件操作等技术。

![[Nuxt.js]Nuxt.js基础 [Nuxt.js]Nuxt.js基础](https://image.dandelioncloud.cn/images/20221123/82b469e3af2648488df508467e906466.png)

还没有评论,来说两句吧...