Python爬虫初体验:常见网络请求和反爬策略

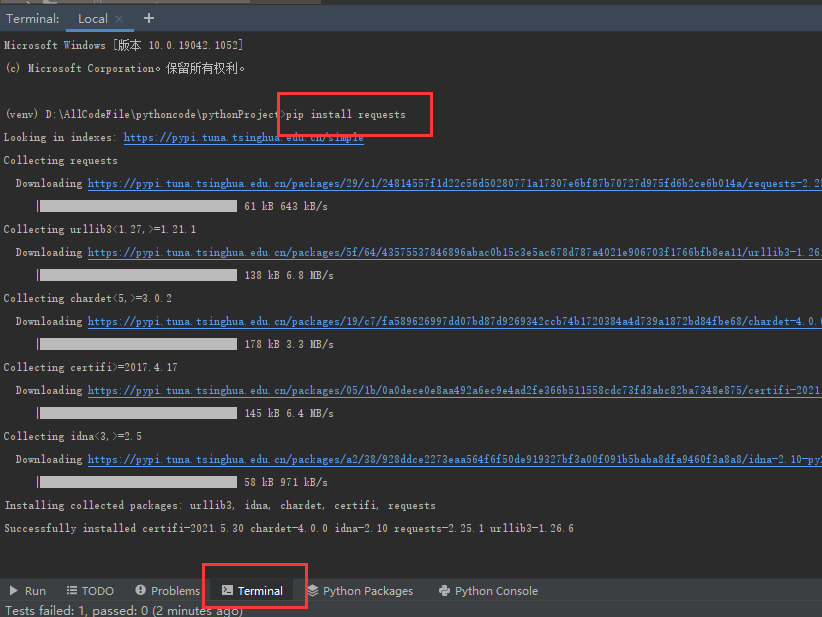

Python爬虫是自动化网站信息获取的重要工具。在初体验时,我们通常会接触到以下几个常见的网络请求方式:

- GET:最常用的请求方式,用于获取指定资源的表示形式,如URL。

例如:

import requestsurl = 'https://example.com page'response = requests.get(url)print(response.text) # 打印页面内容

- POST:用于向服务器提交数据。常见的应用场景包括注册、登录、评论等。

例如:

import requestsurl = 'https://example.com/login'data = {'username': 'your_username', 'password': 'your_password'} # 要提交的数据response = requests.post(url, data=data)if response.status_code == 200: # 成功状态码print('Login successful!')else:print('Failed to login. Error code:', response.status_code)

PUT:用于更新指定资源。通常配合URL一起使用,以明确目标资源。

DELETE:用于删除指定的资源。

在进行网络爬虫时,我们还需要关注一些反爬策略:

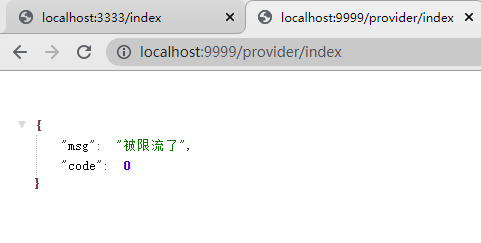

IP限制:网站可能通过IP地址来控制访问量。我们需要获取稳定且可用的IP。

User-Agent检测:网站可以通过识别浏览器信息(如User-Agent)来判断是否为爬虫。

验证码和登录验证:部分网站会设置验证码或登录验证,以防止机器人直接操作。

动态加载内容:一些网站会采用JavaScript动态加载内容,这需要爬虫能解析并执行JavaScript代码。

总之,Python爬虫入门需要熟悉网络请求方式,并了解反爬策略以保证爬虫的稳定性和合法性。

还没有评论,来说两句吧...