使用Python进行网络爬虫时,常见问题与解决策略

在网络爬虫的开发过程中,可能会遇到以下几种常见的问题,以及相应的解决策略:

URL结构复杂:如果网站的链接结构不清晰,如动态加载、面包屑导航等,可以使用像

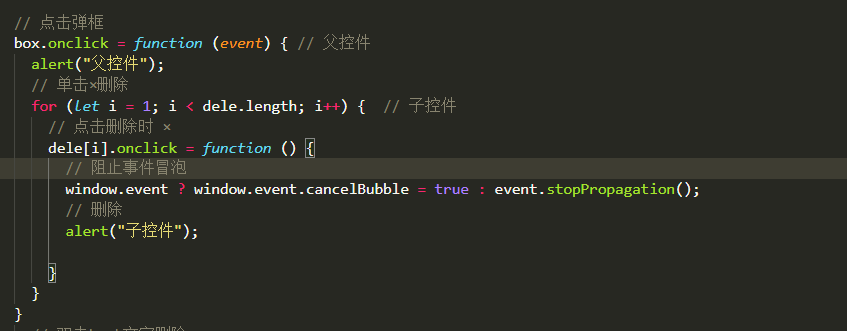

beautifulsoup4这样的库来解析HTML。反爬机制:许多网站会设置防止爬虫访问的机制,如IP封锁、验证码、cookies等。对于这类问题,需要根据具体的反爬策略进行应对,比如使用代理IP、模拟人类行为解决验证码问题、保存并使用cookies等。

法律法规限制:在某些国家和地区,网络爬虫可能受到法律的限制。这种情况下,需要遵守当地的法律法规,或者寻求合法的爬虫方式。

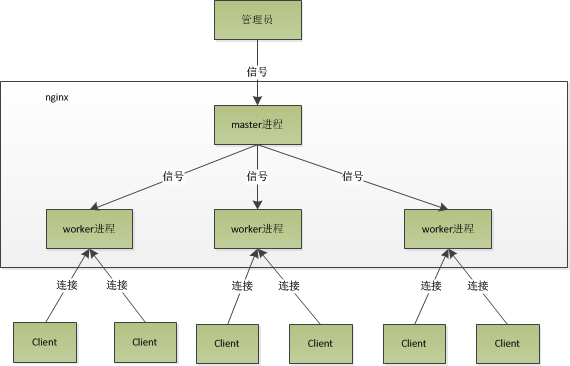

数据量大或更新频繁:如果网站的数据量非常大,或者每天都有大量新内容产生,单纯使用Python爬虫可能效率不高。这时可以考虑使用分布式爬虫框架如Scrapy等来提高爬取速度和灵活性。

还没有评论,来说两句吧...