Python爬虫:如何解决requests库请求被阻止的问题?

在使用requests库进行网络请求时,如果遇到请求被阻止(如403 Forbidden或503 Service Unavailable等)的情况,可以尝试以下几种解决方案:

检查IP:

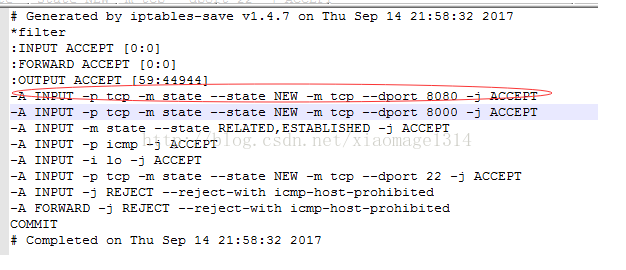

如果你在一个需要登录或者有IP限制的地方做爬虫,检查并确保你的IP没有被对方封锁。更换代理:

使用代理服务器进行网络请求,可以有效避免IP被封的问题。Python中有很多可以使用的代理库,如proxybroker、random-proxies等。设置合适的请求头:

根据目标网站的策略,正确设置User-Agent和其他可能需要的请求头。检查URL是否有问题:

确保你请求的URL是有效的,并且能够正常返回响应。

请注意,不同的网站可能会有不同的处理策略,因此在尝试解决这类问题时,要灵活应对。

还没有评论,来说两句吧...