Python爬虫遇到的网页限制问题

在Python爬虫中,遇到网页限制的情况主要有以下几种:

反爬机制:许多网站为了防止爬虫频繁访问,会设置反爬策略,如检查User-Agent、验证码识别、IP限流等。

登录墙:部分网站需要用户登录才能访问内容。此时你需要通过解析登录页面,抓取登录凭证(如用户名和密码),然后提交登录请求。

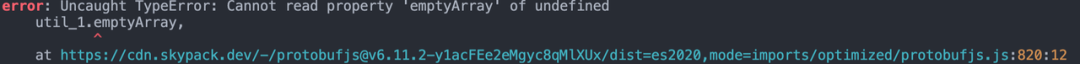

JavaScript渲染:一些网页的动态内容是由JavaScript处理完成的。爬虫如果直接获取HTML,可能会错过这些内容。解决方法是使用浏览器自动化工具(如Selenium)来模拟浏览器行为,从而获取到包含JavaScript内容的网页。

遇到这类问题时,建议你先对目标网站进行分析,了解其反爬策略和特点。然后选择合适的方法来解决问题。

还没有评论,来说两句吧...