tensorflow逻辑回归框架

小彩笔的摸爬滚打之路orz

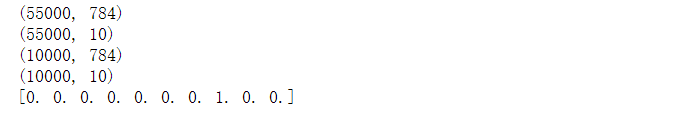

import numpy as npimport tensorflow as tfimport matplotlib.pyplot as pltimport input_datamnist = input_data.read_data_sets('data/', one_hot=True)trainimg = mnist.train.imagestrainlabel = mnist.train.labelstestimg = mnist.test.imagestestlabel = mnist.test.labelsprint ("MNIST loaded")print (trainimg.shape)print (trainlabel.shape)print (testimg.shape)print (testlabel.shape)#print (trainimg)print (trainlabel[0])

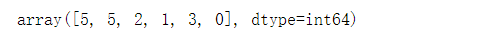

x = tf.placeholder("float", [None, 784])y = tf.placeholder("float", [None, 10]) # None is for infiniteW = tf.Variable(tf.zeros([784, 10]))b = tf.Variable(tf.zeros([10]))# LOGISTIC REGRESSION MODELactv = tf.nn.softmax(tf.matmul(x, W) + b)# COST FUNCTIONcost = tf.reduce_mean(-tf.reduce_sum(y*tf.log(actv), reduction_indices=1))# OPTIMIZERlearning_rate = 0.01optm = tf.train.GradientDescentOptimizer(learning_rate).minimize(cost)# PREDICTIONpred = tf.equal(tf.argmax(actv, 1), tf.argmax(y, 1))# ACCURACYaccr = tf.reduce_mean(tf.cast(pred, "float"))# INITIALIZERinit = tf.global_variables_initializer()# argmax函数讲解sess = tf.InteractiveSession()arr = np.array([[31, 23, 4, 24, 27, 34],[18, 3, 25, 0, 6, 35],[28, 14, 33, 22, 20, 8],[13, 30, 21, 19, 7, 9],[16, 1, 26, 32, 2, 29],[17, 12, 5, 11, 10, 15]])#tf.rank(arr).eval() 矩阵维度#tf.shape(arr).eval()#tf.argmax(arr, 0).eval() 求最大值索引,0对应每一列,1对应每一行,返回的都是所在的列号# 0 -> 31 (arr[0, 0])# 3 -> 30 (arr[3, 1])# 2 -> 33 (arr[2, 2])tf.argmax(arr, 1).eval()# 5 -> 34 (arr[0, 5])# 5 -> 35 (arr[1, 5])# 2 -> 33 (arr[2, 2])

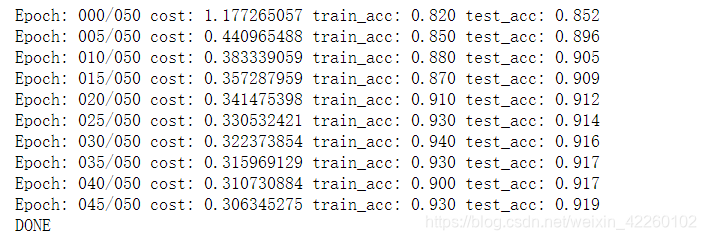

training_epochs = 50batch_size = 100display_step = 5# SESSIONsess = tf.Session()sess.run(init)# MINI-BATCH LEARNINGfor epoch in range(training_epochs):avg_cost = 0.num_batch = int(mnist.train.num_examples/batch_size)for i in range(num_batch):batch_xs, batch_ys = mnist.train.next_batch(batch_size)sess.run(optm, feed_dict={ x: batch_xs, y: batch_ys})feeds = { x: batch_xs, y: batch_ys}avg_cost += sess.run(cost, feed_dict=feeds)/num_batch# DISPLAYif epoch % display_step == 0:feeds_train = { x: batch_xs, y: batch_ys}feeds_test = { x: mnist.test.images, y: mnist.test.labels}train_acc = sess.run(accr, feed_dict=feeds_train)test_acc = sess.run(accr, feed_dict=feeds_test)print ("Epoch: %03d/%03d cost: %.9f train_acc: %.3f test_acc: %.3f"% (epoch, training_epochs, avg_cost, train_acc, test_acc))print ("DONE")

还没有评论,来说两句吧...