【转】python-word2vec模块使用详解

安装

安装方法:pip install --upgrade gensim

安装分词:pip install jieba

中文训练预料处理

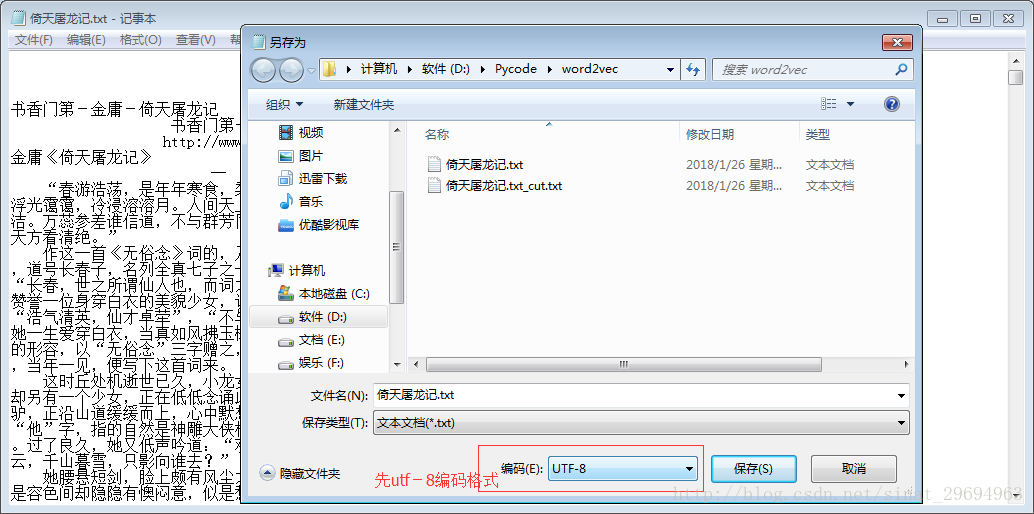

首先去网上下载一本小书,然后将其另存为utf-8格式

文本文件准备好,现在开始用python对此txt文档进行处理。

from gensim.models import word2vecimport osimport gensimfrom word2vec import model_trainimport jieba# 此函数作用是对初始语料进行分词处理后,作为训练模型的语料def cut_txt(old_file):global cut_file # 分词之后保存的文件名cut_file = old_file + '_cut.txt'try:fi = open(old_file, 'r', encoding='utf-8')except BaseException as e: # 因BaseException是所有错误的基类,用它可以获得所有错误类型print(Exception, ":", e) # 追踪错误详细信息text = fi.read() # 获取文本内容new_text = jieba.cut(text, cut_all=False) # 精确模式str_out = ' '.join(new_text).replace(',', '').replace('。', '').replace('?', '').replace('!', '') \.replace('“', '').replace('”', '').replace(':', '').replace('…', '').replace('(', '').replace(')', '') \.replace('—', '').replace('《', '').replace('》', '').replace('、', '').replace('‘', '') \.replace('’', '') # 去掉标点符号fo = open(cut_file, 'w', encoding='utf-8')fo.write(str_out)

注意open中必须指明编码方式,否则就会报错;上面的函数若要单独运行,须要更改old_file变量为原文件名。

模型训练

准备好训练语料(注意训练语料文件越大越好,越大最后的训练效果越好),之后就开始写训练模型了,训练模型的代码如下所示:

from gensim.models import word2vecimport gensimimport loggingdef model_train(train_file_name, save_model_file): # model_file_name为训练语料的路径,save_model为保存模型名# 模型训练,生成词向量logging.basicConfig(format='%(asctime)s : %(levelname)s : %(message)s', level=logging.INFO)sentences = word2vec.Text8Corpus(train_file_name) # 加载语料model = gensim.models.Word2Vec(sentences, size=200) # 训练skip-gram模型; 默认window=5model.save(save_model_file)model.wv.save_word2vec_format(save_model_file + ".bin", binary=True) # 以二进制类型保存模型以便重用

参数说明:

model=gensim.models.Word2Vec(sentences,sg=1,size=100,window=5,min_count=2,negative=3,sample=0.001,hs=1,workers=4)#该步骤也可分解为以下三步(但没必要):#model=gensim.model.Word2Vec() 建立一个空的模型对象#model.build_vocab(sentences) 遍历一次语料库建立词典#model.train(sentences) 第二次遍历语料库建立神经网络模型#sg=1是skip—gram算法,对低频词敏感,默认sg=0为CBOW算法#size是神经网络层数,值太大则会耗内存并使算法计算变慢,一般值取为100到200之间。#window是句子中当前词与目标词之间的最大距离,3表示在目标词前看3-b个词,后面看b个词(b在0-3之间随机)#min_count是对词进行过滤,频率小于min-count的单词则会被忽视,默认值为5。#negative和sample可根据训练结果进行微调,sample表示更高频率的词被随机下采样到所设置的阈值,默认值为1e-3,#negative: 如果>0,则会采用negativesamping,用于设置多少个noise words#hs=1表示层级softmax将会被使用,默认hs=0且negative不为0,则负采样将会被选择使用。#workers是线程数,此参数只有在安装了Cpython后才有效,否则只能使用单核

我们并不需要全部了解,大部分参数都可以使用其默认值(不输入),而其中比较重要的有:

# min_count,是去除小于min_count的单词# size,神经网络层数# sg, 算法选择# window, 句子中当前词与目标词之间的最大距离# workers,线程数

训练后的模型用普通方式和二进制方式进行保存,以便下次直接使用,避免每次训练耗费大量时间。

word2vec模型调用

两个功能都以函数方式实现了,现在准备编写主函数代码,在主函数中负责调用各个方法实现预处理和模型训练,以此做后面的相关计算。

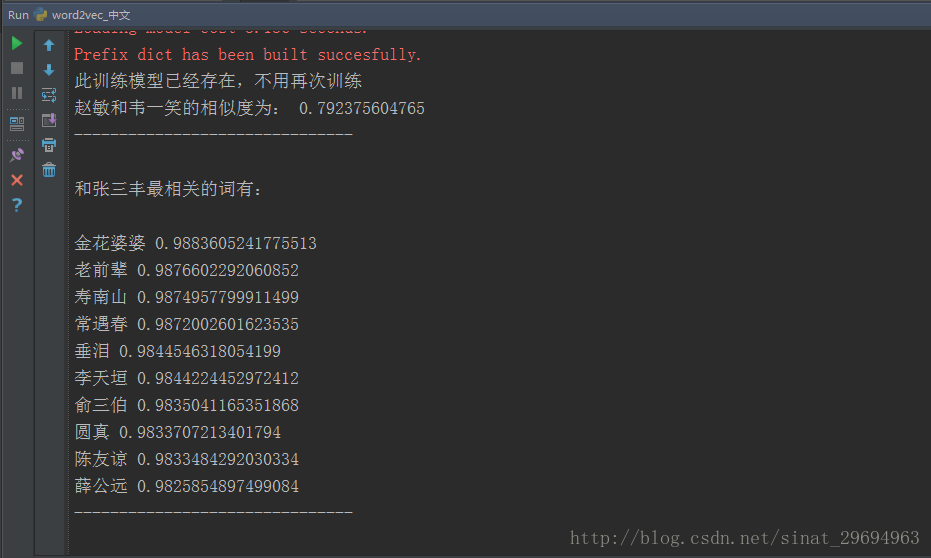

# if not os.path.exists(cut_file): # 判断文件是否存在,参考:https://www.cnblogs.com/jhao/p/7243043.htmlcut_txt('倚天屠龙记.txt') # 须注意文件必须先另存为utf-8编码格式save_model_name = '倚天屠龙记.model'if not os.path.exists(save_model_name): # 判断文件是否存在model_train(cut_file, save_model_name)else:print('此训练模型已经存在,不用再次训练')# 加载已训练好的模型model_1 = word2vec.Word2Vec.load(save_model_name)# 计算两个词的相似度/相关程度word_1 = "金毛狮"word_2 = "谢逊"y1 = model_1.similarity(word_1, word_2)print(word_1, "和", word_2, "的相似度为:", y1)print("-------------------------------\n")# 计算某个词的相关词列表word_3 = "张无忌"y2 = model_1.most_similar(word_3, topn=10) # 10个最相关的print(u"和", word_3, "最相关的词有:\n")for item in y2:print(item[0], item[1])print("-------------------------------\n")# 某个词的词向量print(model_1['张无忌'])

最后的运行结果如下所示:

最终的结果一定程序上还是取决于分词的准确率,使用jieba分词时可以针对性的加入用户自定义词典(jieba.load_userdict(“userDict.txt”) # 加载用户自定义词典),可以提高对人名,地名等未登陆词的识别效果,提高分词性能。

还没有评论,来说两句吧...