kubeadm部署k8s集群

kubernetes 官方提供的三种部署方式

minikube

Minikube是一个工具,可以在本地快速运行一个单点的Kubernetes,仅用于尝试Kubernetes或日常开发的用户使用。部署地址:https://kubernetes.io/docs/setup/minikube/

kubeadm

Kubeadm也是一个工具,提供kubeadm init和kubeadm

join,用于快速部署Kubernetes集群。部署地址:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/二进制包

从官方下载发行版的二进制包,手动部署每个组件,组成Kubernetes集群。下载地址:https://github.com/kubernetes/kubernetes/releases

今天我们使用kubeadm部署k8s集群

1. 设置linux环境(每个节点都执行)

-- 禁用防火墙systemctl stop firewalld-- 停止并禁用开机启动systemctl disable firewalld-- 关闭selinux(关闭linux默认的安全策略,不关闭会修改/etc/selinux/config的内容)sed -i 's/enforcing/disabled/' /etc/selinux/config-- 把当前会话的默认安全策略也禁掉(或者重启虚拟机应该也可,我是这样理解的)setenforce 0-- 关闭swap(关闭内存交换)(开启内存交换的话,性能会出现很大的问题)swapoff -a (临时的,只针对当前会话起作用,若会话关闭,重开还是会开启内存交换,所以使用下面一行命令即可)sed -ri 's/.*swap.*/#&/' /etc/fstab (永久关闭)# free -g 验证,swap必须为0;-- 添加主机名与IP对应关系(注意:主机名一定不能是localhost,如果是,使用下面命令修改主机名)vi /etc/hosts192.168.12.132 k8s-master192.168.12.133 k8s-node1192.168.12.134 k8s-node2-- 查看主机名命令hostname-- 修改主机名命令sudo hostnamectl set-hostname <newhostname>-- 将桥接的IPv4流量传递到iptables的链--(如果不执行可能会有些流量统计指标的消失,为了让更精确的统计流量,所以执行此命令)cat > /etc/sysctl.d/k8s.conf << EOFnet.bridge.bridge-nf-call-ip6tables = 1net.bridge.bridge-nf-call-iptables = 1EOF-- 让系统应用此规则sysctl --system

疑难问题:

– 遇见提示是只读的文件系统,运行如下命令

mount -o remount rw /date 查看时间(可选)

yum install -y ntpdate

ntpdate time.windows.com 同步最新时间

2. 安装docker、kubeadm、kubelet、kubectl(每个节点都执行)

docker安装查看我之前的文章即可,这里不过多赘述:https://blog.csdn.net/RookiexiaoMu_a/article/details/119081868

- kubeadm:用来初始化集群的指令。

- kubelet:在集群中的每个节点上用来启动 Pod 和容器等。

kubectl:用来与集群通信的命令行工具。

— 添加阿里云yum源(告诉linux,kubeadm在哪里安装)

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF— 检查yum源是不是有跟kube相关的安装源

yum list | grep kube

— 指定版本安装

yum install -y kubelet-1.17.3 kubeadm-1.17.3 kubectl-1.17.3

— 设置开机自启

systemctl enable kubelet

— 启动kubelet

systemctl start kubelet

3. 下载master需要的镜像(master节点执行即可)

将文件:master_images.sh传输到linux

master_images.sh文件内容如下:

#!/bin/bashimages=(kube-apiserver:v1.17.3kube-proxy:v1.17.3kube-controller-manager:v1.17.3kube-scheduler:v1.17.3coredns:1.6.5etcd:3.4.3-0pause:3.1)for imageName in ${ images[@]} ; dodocker pull registry.cn-hangzhou.aliyuncs.com/google_containers/$imageName# docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/$imageName k8s.gcr.io/$imageNamedone

给master_images.sh文件执行的权限:

-- 给文件执行的权限chmod 700 master_images.sh

执行:

./master_images.sh

若在】运行该脚本出现如下错误。

./master_images.sh

-bash: ./master_images.sh: /bin/bash^M: 坏的解释器: 没有那个文件或目录

原因

在Windows系统上编写的Shell脚本,然后上传到Linux服务器执行。

Windows系统中的换行符是**\n\r**,Linux系统中的换行符是**\n**,因此需要将**\r**替换为空白。

解决方案

Linux sed命令可自动编辑一个或多个文件,执行以下命令即可。

sed -i ‘s/\r$//’ master_images.sh

注意:是英文的单引号,而不是中文的单引号

4.构建master节点(master节点执行即可)

在master节点执行一下命令

kubeadm init \--apiserver-advertise-address=192.168.12.132 \--image-repository registry.cn-hangzhou.aliyuncs.com/google_containers \--kubernetes-version v1.17.3 \--service-cidr=192.96.0.0/16 \--pod-network-cidr=192.244.0.0/16

– 命令解析:第二行:指定apiserver的地址,即master节点的地址

– 第三行:由于master初始化需要下载很多镜像,默认是从k8s.gcr.io拉取镜像,k8s.gcr.io镜像地址国内无法访问,这里指定阿里云镜像仓库地址。

– 第四行:kubernetes版本

– 第五行:service网络

– 第六行:pod网络

– cidr

科普:无类别域间路由(Classless Inter-Domain Routing、CIDR)是一个用于给用户分配IP地址以及在互联网上有效地路由IP数据包的对IP地址进行归类的方法。

第五行建议使用:–service-cidr=10.96.0.0/16

第六行建议使用:–pod-network-cidr=10.244.0.0/16

因为后续安装flannel默认的网段是10.244.0.0

为了导致不必要的麻烦所以建议使用

注意:一定要关闭内存交换,否则会初始化失败

成功之后可以看到以下相似内容:

mkdir -p $HOME/.kubesudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/configsudo chown $(id -u):$(id -g) $HOME/.kube/confighttps://kubernetes.io/docs/concepts/cluster-administration/addons/kubeadm join 192.168.12.132:6443 --token 52vuzh.z54kubq02bumxxoc \--discovery-token-ca-cert-hash sha256:abf12d2c8debd8535d1fe086c44c184569a6655ac39cfd66fa156ee890373e1e

将第一段复制下来执行:

mkdir -p $HOME/.kubesudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/configsudo chown $(id -u):$(id -g) $HOME/.kube/config

将第三段复制下来,在另外两台虚拟机执行:

【让另外两台节点加入这个集群,注:token的有效时长为2小时】

kubeadm join 192.168.12.132:6443 --token 52vuzh.z54kubq02bumxxoc \--discovery-token-ca-cert-hash sha256:abf12d2c8debd8535d1fe086c44c184569a6655ac39cfd66fa156ee890373e1e

– token过期怎么办?执行红色字体命令,将控制台的内容复制到另外两台节点执行即可(此生成的token是永久有效的token)

#kubeadm token create —print-join-command

kubeadm token create —ttl 0 —print-join-command

kubeadm join —token y1eyw5.ylg568kvohfdsfco —discovery-token-ca-cert-hash

sha256:6c35e4f73f72afd89bf1c8c303ee55677d2cdb1342d67bb23c852aba2efc7c73

4.1安装pod网络插件:flannel网络规划服务(master节点执行即可)

flannel的作用以及介绍在下文会有介绍

执行命令:

$ kubectl apply -f \https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

若是报错:未找到命令,或者文档下载不下来,可使用小编的这个文件:kube-flannel.yml,上传到linux上。

kube-flannel.yml内容如下:

---apiVersion: policy/v1beta1kind: PodSecurityPolicymetadata:name: psp.flannel.unprivilegedannotations:seccomp.security.alpha.kubernetes.io/allowedProfileNames: docker/defaultseccomp.security.alpha.kubernetes.io/defaultProfileName: docker/defaultapparmor.security.beta.kubernetes.io/allowedProfileNames: runtime/defaultapparmor.security.beta.kubernetes.io/defaultProfileName: runtime/defaultspec:privileged: falsevolumes:- configMap- secret- emptyDir- hostPathallowedHostPaths:- pathPrefix: "/etc/cni/net.d"- pathPrefix: "/etc/kube-flannel"- pathPrefix: "/run/flannel"readOnlyRootFilesystem: false# Users and groupsrunAsUser:rule: RunAsAnysupplementalGroups:rule: RunAsAnyfsGroup:rule: RunAsAny# Privilege EscalationallowPrivilegeEscalation: falsedefaultAllowPrivilegeEscalation: false# CapabilitiesallowedCapabilities: ['NET_ADMIN', 'NET_RAW']defaultAddCapabilities: []requiredDropCapabilities: []# Host namespaceshostPID: falsehostIPC: falsehostNetwork: truehostPorts:- min: 0max: 65535# SELinuxseLinux:# SELinux is unused in CaaSPrule: 'RunAsAny'---kind: ClusterRoleapiVersion: rbac.authorization.k8s.io/v1metadata:name: flannelrules:- apiGroups: ['extensions']resources: ['podsecuritypolicies']verbs: ['use']resourceNames: ['psp.flannel.unprivileged']- apiGroups:- ""resources:- podsverbs:- get- apiGroups:- ""resources:- nodesverbs:- list- watch- apiGroups:- ""resources:- nodes/statusverbs:- patch---kind: ClusterRoleBindingapiVersion: rbac.authorization.k8s.io/v1metadata:name: flannelroleRef:apiGroup: rbac.authorization.k8s.iokind: ClusterRolename: flannelsubjects:- kind: ServiceAccountname: flannelnamespace: kube-system---apiVersion: v1kind: ServiceAccountmetadata:name: flannelnamespace: kube-system---kind: ConfigMapapiVersion: v1metadata:name: kube-flannel-cfgnamespace: kube-systemlabels:tier: nodeapp: flanneldata:cni-conf.json: | { "name": "cbr0", "cniVersion": "0.3.1", "plugins": [ { "type": "flannel", "delegate": { "hairpinMode": true, "isDefaultGateway": true } }, { "type": "portmap", "capabilities": { "portMappings": true } } ] }net-conf.json: | { "Network": "10.244.0.0/16", "Backend": { "Type": "vxlan" } }---apiVersion: apps/v1kind: DaemonSetmetadata:name: kube-flannel-dsnamespace: kube-systemlabels:tier: nodeapp: flannelspec:selector:matchLabels:app: flanneltemplate:metadata:labels:tier: nodeapp: flannelspec:affinity:nodeAffinity:requiredDuringSchedulingIgnoredDuringExecution:nodeSelectorTerms:- matchExpressions:- key: kubernetes.io/osoperator: Invalues:- linuxhostNetwork: truepriorityClassName: system-node-criticaltolerations:- operator: Existseffect: NoScheduleserviceAccountName: flannelinitContainers:- name: install-cniimage: quay.io/coreos/flannel:v0.14.0command:- cpargs:- -f- /etc/kube-flannel/cni-conf.json- /etc/cni/net.d/10-flannel.conflistvolumeMounts:- name: cnimountPath: /etc/cni/net.d- name: flannel-cfgmountPath: /etc/kube-flannel/containers:- name: kube-flannelimage: quay.io/coreos/flannel:v0.14.0command:- /opt/bin/flanneldargs:- --ip-masq- --kube-subnet-mgrresources:requests:cpu: "100m"memory: "50Mi"limits:cpu: "100m"memory: "50Mi"securityContext:privileged: falsecapabilities:add: ["NET_ADMIN", "NET_RAW"]env:- name: POD_NAMEvalueFrom:fieldRef:fieldPath: metadata.name- name: POD_NAMESPACEvalueFrom:fieldRef:fieldPath: metadata.namespacevolumeMounts:- name: runmountPath: /run/flannel- name: flannel-cfgmountPath: /etc/kube-flannel/volumes:- name: runhostPath:path: /run/flannel- name: cnihostPath:path: /etc/cni/net.d- name: flannel-cfgconfigMap:name: kube-flannel-cfg

Flannel简介:

Flannel是CoreOS团队针对Kubernetes设计的一个网络规划服务,简单来说,它的功能是让集群中的不同节点主机创建的Docker容器都具有全集群唯一的虚拟IP地址。

在默认的Docker配置中,每个节点上的Docker服务会分别负责所在节点容器的IP分配。这样导致的一个问题是,不同节点上容器可能获得相同的内外IP地址。并使这些容器之间能够之间通过IP地址相互找到,也就是相互ping通。

Flannel的设计目的就是为集群中的所有节点重新规划IP地址的使用规则,从而使得不同节点上的容器能够获得“同属一个内网”且”不重复的”IP地址,并让属于不同节点上的容器能够直接通过内网IP通信。

Flannel实质上是一种“覆盖网络(overlaynetwork)”,也就是将TCP数据包装在另一种网络包里面进行路由转发和通信,目前已经支持udp、vxlan、host-gw、aws-vpc、gce和alloc路由等数据转发方式,默认的节点间数据通信方式是UDP转发。Flannel特点:

1.使集群中的不同Node主机创建的Docker容器都具有全集群唯一的虚拟IP地址。

2.建立一个覆盖网络(overlay network),通过这个覆盖网络,将数据包原封不动的传递到目标容器。覆盖网络是建立在另一个网络之上并由其基础设施支持的虚拟网络。覆盖网络通过将一个分组封装在另一个分组内来将网络服务与底层基础设施分离。在将封装的数据包转发到端点后,将其解封装。

3.创建一个新的虚拟网卡flannel0接收docker网桥的数据,通过维护路由表,对接收到的数据进行封包和转发(vxlan)。

4.etcd保证了所有node上flanned所看到的配置是一致的。同时每个node上的flanned监听etcd上的数据变化,实时感知集群中node的变化。

执行命令:(应用此配置文件)

kubectl apply -f kube-flannel.yml

若想将kube-flannel.yml指定的资源全部删除,使用命令:

kubectl delete -f kube-flannel.yml

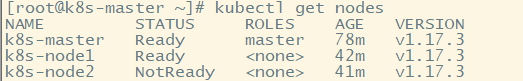

查看k8s集群的节点,在master执行:

kubectl get nodes

可以看到这里是有三个节点,但是有一个状态是:NotReady

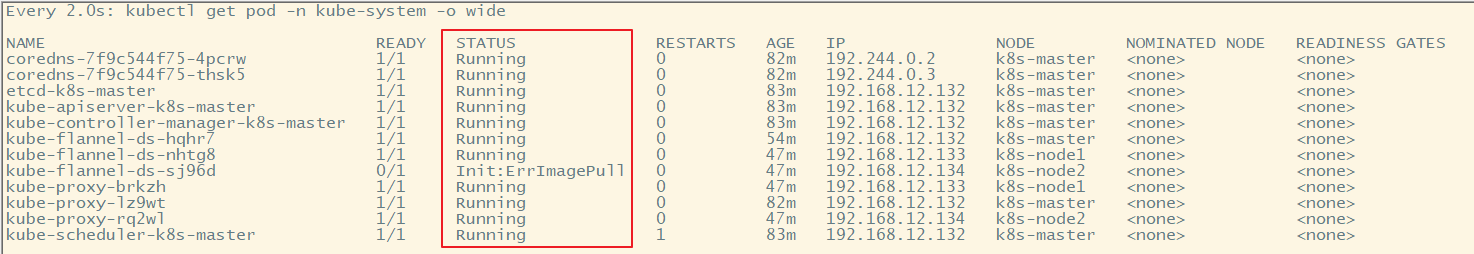

使用以下命令监控pod的进度

-- 监控pod进度watch kubectl get pod -n kube-system -o wide

可以看到pod的状态,小编的flannel有一个没有启动,需要都启动才行:

如果flannel没启动的,重启虚拟机,然后启动docker、启动kubectl

若是设置了docker、kubectl开机自启,那就不用手动启动docker、kubectl了

– 设置开机自启

systemctl enable kubelet

– 启动kubelet

systemctl start kubelet

– 设置开机自启

systemctl enable docker

– 启动docker

systemctl start docker

还没有评论,来说两句吧...