转Parquet文件

介绍:

Apache Parquet is a columnar storage format available to any project in the Hadoop ecosystem, regardless of the choice of data processing framework, data model or programming language.

(Apache Parquet 是一种基于列式存储的文件格式,可用于Hadoop生态系统中的任何项目,无论选着任何数据处理框架,数据模型或编程语言)

Spark SQL提供支持读和写Parquet文件的功能,这些文件可以自动地保留原始数据的模式。

文件存储格式

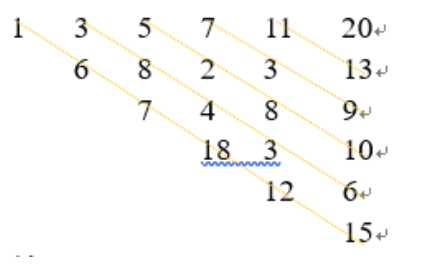

![Image 1][]

这是官网放的一张图:

Magic Number:

幻数,它可以用来标记文件或者协议的格式,很多文件都有幻数标志来表明该文件的格式。(说明文件格式)

4-byte magic number "PAR1"<Column 1 Chunk 1 + Column Metadata><Column 2 Chunk 1 + Column Metadata>...<Column N Chunk 1 + Column Metadata><Column 1 Chunk 2 + Column Metadata><Column 2 Chunk 2 + Column Metadata>...<Column N Chunk 2 + Column Metadata>...<Column 1 Chunk M + Column Metadata><Column 2 Chunk M + Column Metadata>...<Column N Chunk M + Column Metadata>File Metadata4-byte length in bytes of file metadata4-byte magic number "PAR1"

Row Group:

N个列在表中, 分成了m个行组,

Metadata:元数据

There are three types of metadata: file metadata, column (chunk) metadata and page header metadata. All thrift structures are serialized using the TCompactProtocol.

下面就说一下操作

在spark-SQL中提供了对parquet的转换

方法一:

一、将日志文件格式化

读取,处理->dataFrame格式

二、dataFrame.write.parquet(resultOutputPath)

在官网中有示例

方法二:在方法一种只能有22个fields

一、创建样例类(自定义的类),并注册自定义类的实现方式

二、将日志文件格式化

读取,处理->dataFrame格式

三、dataFrame.write.parquet(resultOutputPath)

[Image 1]:

![sublime text3 提示[WinError 2] 系统找不到指定的文件 sublime text3 提示[WinError 2] 系统找不到指定的文件](https://image.dandelioncloud.cn/images/20221021/7c2d64239b9e47b8999ee78cb4480121.png)

还没有评论,来说两句吧...