Hadoop-3.hdfs集群

目录:

准备三台主机(01主机、02主机、03主机)

- 修改mac地址

虚拟机-设置-网络适配器-高级-mac地址-生成 - 修改主机名

执行:hostnamectl set-hostname keduox01/keduox02/keduox03

然后执行注销:logout

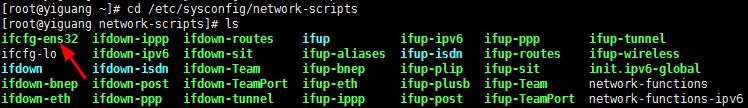

重新登录即可看到已经修改 - 修改ip地址

- 修改mac地址

三台主机安装jdk

- 在01号主机安装jdk,并配置环境变量

- 在02号主机安装jdk,并配置环境变量

- 在03号主机安装jdk,并配置环境变量

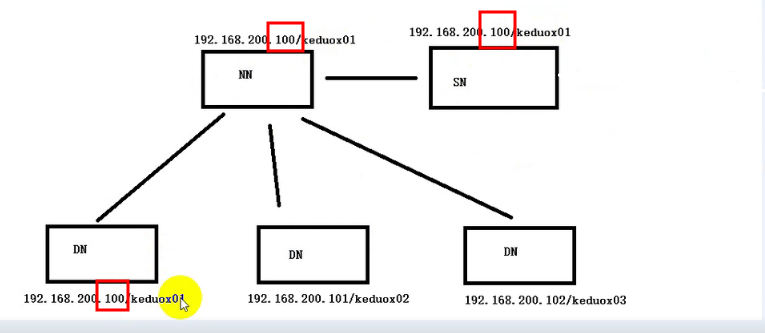

三台主机安装hadoop

- 在01号主机安装hadoop,并配置环境变量,并配置hdfs(01号主机有三个节点NN、SN、DN)

- 在02号主机安装hadoop,并配置环境变量,并配置hdfs(一个DN)

- 在03号主机安装hadoop,并配置环境变量,并配置hdfs(一个DN)

- 改进:将SN放到02号主机

一.三台主机安装jdk

具体步骤:

安装jdk,安装在统一的目录下

在三台主机下都在根目录下创建keduox目录,执行以下两条命令[root@keduox01]# cd /[root@keduox01]# mkdir keduox

可以看到跟目录:![20190122230906629.png][]

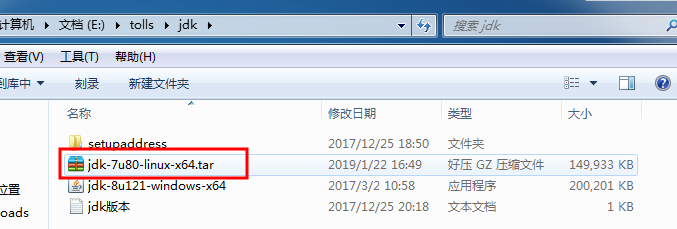

- 在oracle官网下载jdk,注意是linux版本.tar文件

- 本地文件上传到linux/keduox/,通过WinSCP软件传送

- 在虚拟机中解压

[root@keduox01 keduox]# tar -zxvf jdk-7u80-linux-x64.tar.gz 配置环境变量

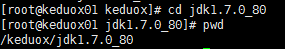

可以将jdk压缩文件删除了- 第一步:获得jdk绝对路径:进入jdk,执行:pwd

得到:

第二步:进入配置文件:[root@keduox01 keduox]# vi /etc/profile

添加:export JAVA_HOME=/keduox/jdk1.7.0_80export PATH=$PATH:$JAVA_HOME/bin

- 第三步:让刚刚修改的profile文件生效:

[root@keduox01 jdk1.7.0_80]# source /etc/profile - 第四步:测试

[root@keduox01 jdk1.7.0_80]# javac

- 第一步:获得jdk绝对路径:进入jdk,执行:pwd

将01号的jdk复制到02号的keduox目录下

- 第一步:将01号的jdk复制到02号的keduox目录下

[root@keduox01 keduox]# scp -r jdk1.7.0_80 root@keduox02:/keduox/

解析:-r 如果是文件夹复制需要加-r - 第二步:可以在02中查看/keduox目录下有了jdk

- 第三步:在02中配置profile文件:可以将在01号中配置好的profile文件复制过去,如果在02的etc/profile文件已经存在,会将其覆盖

命令:scp /etc/profile root@keduox2:/etc/profile

- 第一步:将01号的jdk复制到02号的keduox目录下

将01号的jdk复制到03号的keduox目录下

- 第一步:将01号的jdk复制到03号的keduox目录下

[root@keduox01 keduox]# scp -r jdk1.7.0_80 root@keduox03:/keduox/

解析:-r 如果是文件夹复制需要加-r - 第二步:可以在03中查看/keduox目录下有了jdk

- 第三步:在03中配置profile文件:可以将在01号中配置好的profile文件复制过去,如果在03的etc/profile文件已经存在,会将其覆盖

命令:scp /etc/profile root@keduox3:/etc/profile

- 第一步:将01号的jdk复制到03号的keduox目录下

二.三台主机安装hadoop:

- 下载hadoop

在01号主机安装hadoop

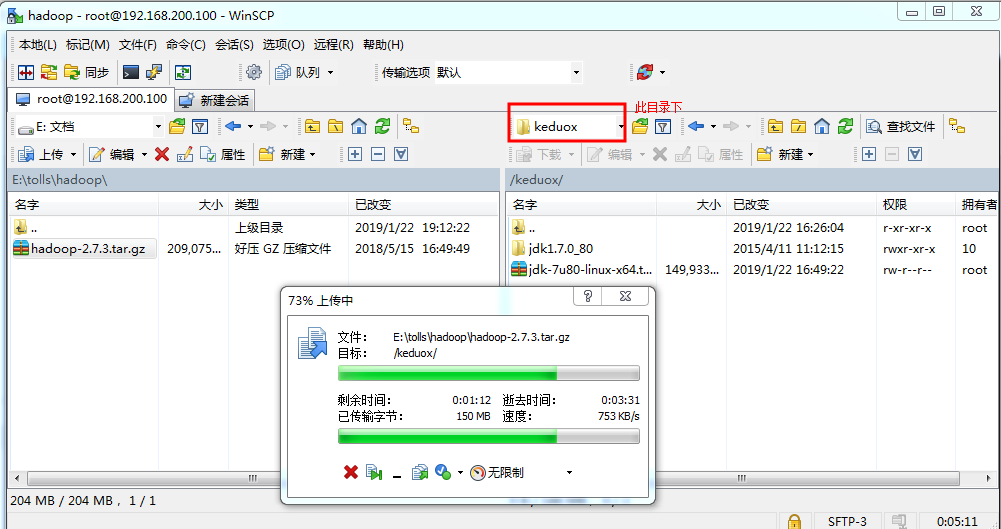

- 将下载好的hadoop上传到01号主机的keduox目录下,并解压

上传:使用WinSCP软件

解压:tar -zxvf hadoop-2.7.3.tar.gz 配置环境变量,在此文件中:/etc/profile

- 第一步:获得hadoop的安装的绝对路径

进入到hadoop的安装目录

执行pwd,即可获得绝对路径 第二步:打开/etc/profile,并配置

vi /etc/profile,在其中添加export HADOOP_HOME=/keduox/hadoop-2.7.3export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

保存退出

- 第三步:source /etc/profile 让修改的信息生效

- 第一步:获得hadoop的安装的绝对路径

- 将下载好的hadoop上传到01号主机的keduox目录下,并解压

在02号主机安装hadoop

可以将01/keduox/hadoop2.7…/doc 先删除- 第一步:将01号主机解压好的hadoop复制到02号主机

scp -r /keduox/hadoop-2.7.3 root@keduox02:/keduox/ - 第二步:将01号主机配置好的profile文件复制到02号主机

scp /etc/profile root@keduox02:/etc/profile

- 第一步:将01号主机解压好的hadoop复制到02号主机

在03号主机安装hadoop(同步骤3)

- 第一步:将01号主机解压好的hadoop复制到03号主机

scp /keduox/hadoop-2.7.3 root@keduox03:/keduox/ - 第二步:将01号主机配置好的profile文件复制到03号主机

scp /etc/profile root@keduox03:/etc/profile

- 第一步:将01号主机解压好的hadoop复制到03号主机

让hadoop和jdk关联

文件位置:

- 第一步:进入hadoop安装目录下

vi /keduox/hadoop-2.7.3/etc/hadoop/hadooop-env.sh

修改其中的

export JAVA_HOME=/keduox/jdk1.7.0_80

:wq 保存退出 第二步:配置统一的入口,还是在hadoop目录下

执行命令:vi /keduox/hadoop-2.7.3/etc/hadoop/core-site.xml,进入修改<configuration><property><name>fs.defaultFS</name><value>hdfs://keduox01:9000</value></property><property><name>hadoop.tmp.dir</name><value>/keduox/hadoopData</value></property></configuration>

- 第三步:配置有哪些DataNode:修改salves文件,在hadoop安装目录下的etc/hadoop/slaves

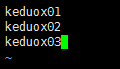

修改为:

保存退出 - 将第一步的配置文件复制到02、03号主机

- 第一步:进入hadoop安装目录下

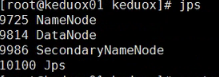

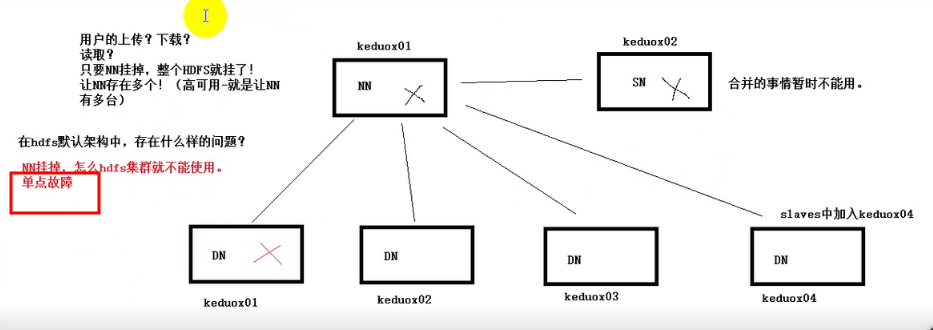

启动dfs

- 首次启动需要格式在NN进行格式化首次启动需要格式化:在NN主机上进行格式化(只需要在NN上)

[root@keduox01 keduox]# hdfs namenode -format - 格式化完成之后,在NN上执行

start-dfs.sh

注:在NN开启之后,ND都会开启,因为ND由NN管理

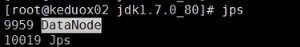

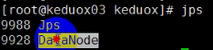

可以在3台主机下执行 jps,查看进程

01号

02号

03号

- 首次启动需要格式在NN进行格式化首次启动需要格式化:在NN主机上进行格式化(只需要在NN上)

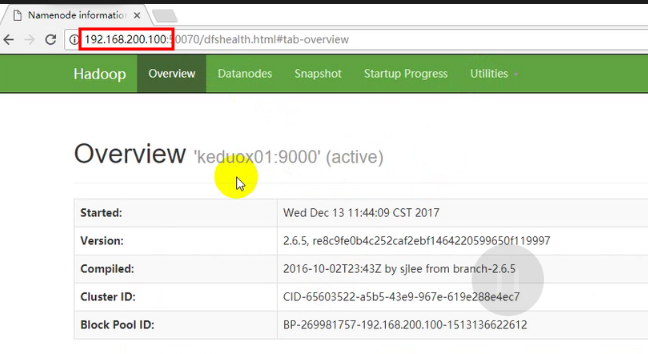

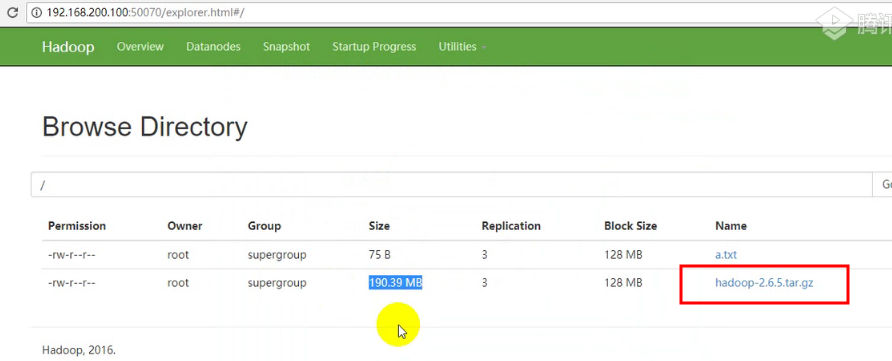

测试:通过浏览器访问

- 第一步:在测试之前需要关闭所有主机的防火墙

systemctl stop firewalld(此次关闭防火墙)

systemctl disable firewalld(以后都禁用掉,下次开启主机才能生效) - 第二步:在浏览器输入:192.168.200.100:50070即可看到dfs界面

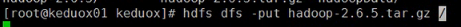

- 第三步:可以上传一个文件在上面,将hadoop下载文件上传上去

- 第一步:在测试之前需要关闭所有主机的防火墙

- 完成。

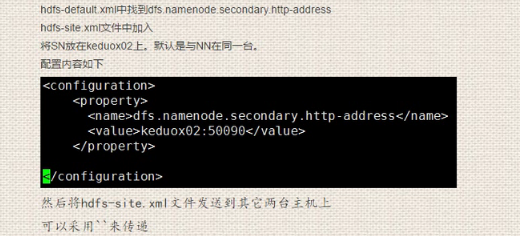

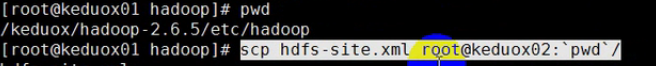

三.改进:将SN放到02号主机

详细步骤:

- 先关闭hdfs

stop -dfs.sh - 下一步:

- 让其生效即可

source [文件]

还没有评论,来说两句吧...