Logback+kafka+ELK搭建微服务日志

Logback+kafka+ELK搭建微服务日志

- 前言

- 环境准备

- 安装zookeeper

- 安装kafka

- 安装elasticsearch

- 安装logstash

- 安装kibana

- 配置Logback

- pom文件改造

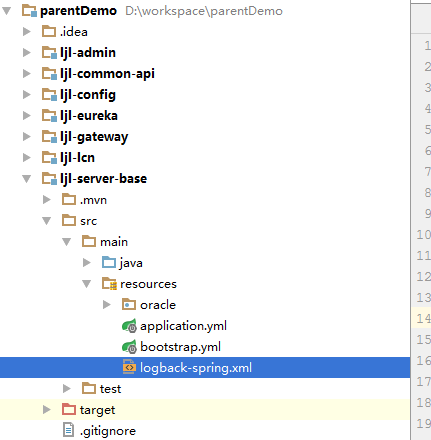

- 新增logback-spring.xml

- boot配置文件一下

- 测试

- kibana使用

前言

微服务下的日志不能采用原先单一架构的日志系统,因为日志文件分散在各个服务器上面,对于排查问题很不友好。我们的目标是把所有的服务产生的日志都聚合到一起。所以采用Logback+kafka+ELK的方法来搭建微服务日志。

大体流程是是通过logback打印日志,然后将日志通过kafka消息队列发送到Logstash,经过处理以后存储到Elasticsearch中,然后通过Kibana图形化界面进行分析和处理。

环境准备

- window环境

- Spring boot 2.0.3.RELEASE

- elasticsearch-7.3.0

- kafka_2.11-2.3.0

- kibana-7.3.0-windows-x86_64

- logstash-7.3.0

- zookeeper-3.4.12

安装zookeeper

下载地址 //mirror.bit.edu.cn/apache/zookeeper/

//mirror.bit.edu.cn/apache/zookeeper/

因为kafka依赖zookeeper,所以我们需要按照zookeeper。下载下来之后直接解压。

将目录中conf下的配置文件 zoo_sample.cfg 重命名 zoo.cfg即可(使用默认配置即可)。

#默认端口2181clientPort=2181之后 双击bin\zkServer.cmd 即可

安装kafka

下载地址 //kafka.apache.org/downloads

//kafka.apache.org/downloads

注意要下载二进制的别下载源码

下载下来之后直接解压。一样使用默认的配置文件即可

# 如果zookeeper的端口修改过 则需要将这里需要改一下zookeeper.connect=localhost:2181(建议把地址改成ip)listeners=PLAINTEXT://172.16.12.67:9092cmd启动 bin\windows>kafka-server-start.bat ..\..\config\server.properties

安装elasticsearch

下载地址 //www.elastic.co/cn/downloads/elasticsearch

//www.elastic.co/cn/downloads/elasticsearch

下载下来之后直接解压。一样使用默认的配置文件即可

双击 bin\elasticsearch.bat

安装logstash

下载地址 //www.elastic.co/cn/downloads/logstash

//www.elastic.co/cn/downloads/logstash

下载下来之后直接解压。

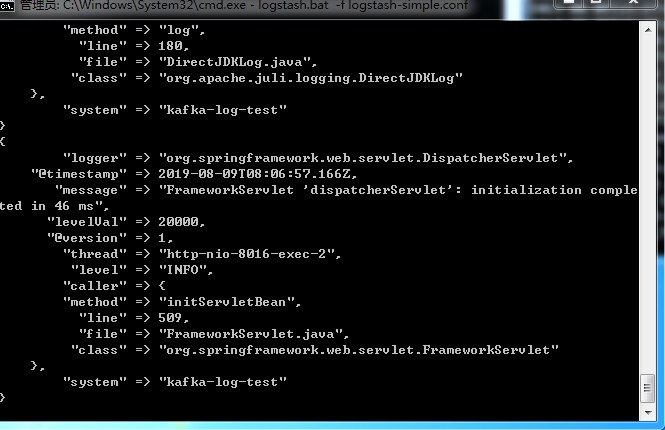

# 修改logstash-simple.con 注意这里写的kafka配置到时候要和Logback配置的一样input {kafka {bootstrap_servers => "172.16.12.67:9092"topics => ["kafka-log"]codec => json}}output {elasticsearch {hosts => ["127.0.0.1:9200"]index => "kafka-log-%{+YYYY.MM.dd}"}stdout{codec=>rubydebug}}cmd启动 logstash.bat -f logstash-simple.conf (我把配置文件放到bin目录下了 不放的话就写配置文件的相对地址)

安装kibana

下载地址 //www.elastic.co/cn/downloads/kibana

//www.elastic.co/cn/downloads/kibana

下载下来之后直接解压。一样使用默认的配置文件即可

双击启动 kibana.bat即可

配置Logback

pom文件改造

<!-- 日志同步至kafka --><dependency><groupId>org.apache.kafka</groupId><artifactId>kafka-clients</artifactId><version>2.1.1</version></dependency><dependency><groupId>net.logstash.logback</groupId><artifactId>logstash-logback-encoder</artifactId><version>4.11</version></dependency><dependency><groupId>com.github.danielwegener</groupId><artifactId>logback-kafka-appender</artifactId><version>0.1.0</version><scope>runtime</scope></dependency>

新增logback-spring.xml

<?xml version="1.0" encoding="UTF-8"?><!-- scan:当此属性设置为true时,配置文件如果发生改变,将会被重新加载,默认值为true。 scanPeriod:设置监测配置文件是否有修改的时间间隔,如果没有给出时间单位,默认单位是毫秒当scan为true时,此属性生效。默认的时间间隔为1分钟。 debug:当此属性设置为true时,将打印出logback内部日志信息,实时查看logback运行状态。默认值为false。 --><!-- <configuration scan="false" scanPeriod="60 seconds" debug="false"> --><configuration><!--设置上下文名称,用于区分不同应用程序的记录。一旦设置不能修改, 可以通过%contextName来打印日志上下文名称 --><contextName>kafka-log-test</contextName><!-- 定义日志的根目录 --><property name="logDir" value="D:/springcloud-log/kafka-log" /><!-- 定义日志文件名称 --><property name="logName" value="kafkaLog"></property><!-- ConsoleAppender 表示控制台输出 --><appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender"><!-- 日志输出格式: %d表示日期时间, %thread表示线程名, %-5level:级别从左显示5个字符宽度, %logger{50}表示logger名字最长50个字符,否则按照句点分割。 %msg:日志消息, %n是换行符 --><encoder><pattern>%d{HH:mm:ss.SSS} %contextName [%thread] %-5level %logger{36} - %msg%n</pattern></encoder></appender><!-- 异常错误日志记录到文件 --><appender name="logfile" class="ch.qos.logback.core.rolling.RollingFileAppender"><!-- <Encoding>UTF-8</Encoding> --><File>${logDir}/${logName}.log</File><rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy"><FileNamePattern>${logDir}/history/${myspringboottest_log}.%d{yyyy-MM-dd}.rar</FileNamePattern><maxHistory>30</maxHistory></rollingPolicy><encoder><pattern>%d{HH:mm:ss.SSS} %contextName [%thread] %-5level %logger{36} - %msg%n</pattern></encoder></appender><appender name="kafkaAppender" class="com.github.danielwegener.logback.kafka.KafkaAppender"><encoder class="com.github.danielwegener.logback.kafka.encoding.LayoutKafkaMessageEncoder"><layout class="net.logstash.logback.layout.LogstashLayout" ><includeContext>false</includeContext><includeCallerData>true</includeCallerData><customFields>{"system":"kafka-log-test"}</customFields><fieldNames class="net.logstash.logback.fieldnames.ShortenedFieldNames"/></layout><charset>UTF-8</charset></encoder><!--kafka topic 需要与配置文件里面的topic一致 否则kafka会沉默并鄙视你--><topic>kafka</topic><keyingStrategy class="com.github.danielwegener.logback.kafka.keying.HostNameKeyingStrategy" /><deliveryStrategy class="com.github.danielwegener.logback.kafka.delivery.AsynchronousDeliveryStrategy" /><producerConfig>bootstrap.servers=172.16.12.67:9092</producerConfig></appender><!--异步写入kafka,尽量不占用主程序的资源--><appender name="ASYNC" class="ch.qos.logback.classic.AsyncAppender"><neverBlock>true</neverBlock><includeCallerData>true</includeCallerData><discardingThreshold>0</discardingThreshold><queueSize>2048</queueSize><appender-ref ref="kafkaAppender" /></appender><root level="INFO"><appender-ref ref="CONSOLE" /><appender-ref ref="logfile"/><appender-ref ref="ASYNC" /></root></configuration>

boot配置文件一下

logging:config: classpath:logback-spring.xml

测试

logger.info("调用成功");

如果出现这种的日志则说明ok了

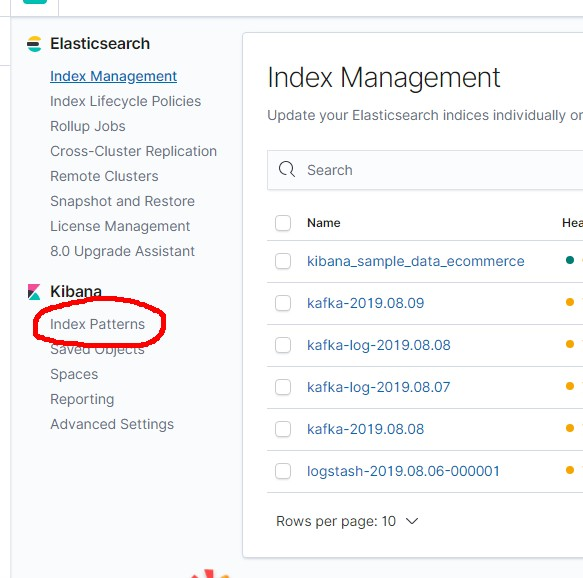

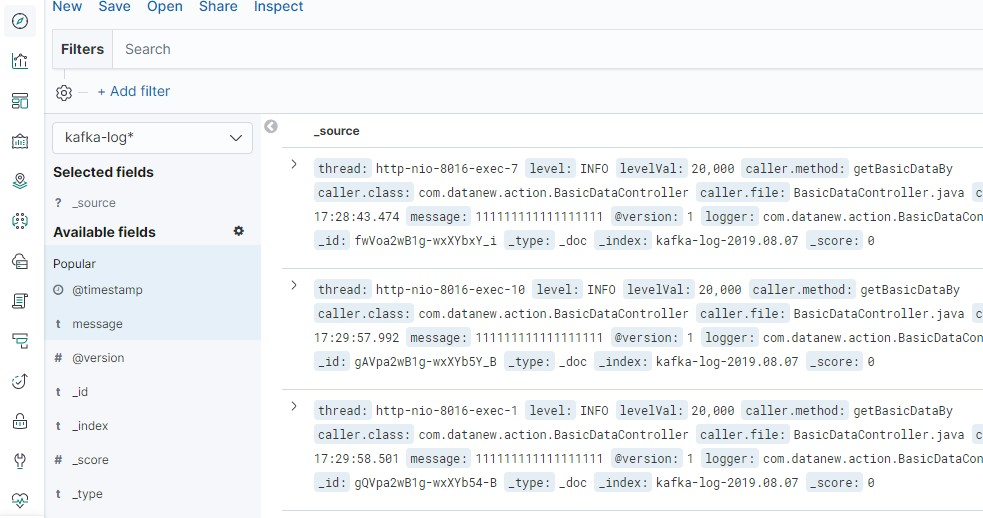

kibana使用

新建一下index patterns 就行了 索引就是logstash配置文件里面配置的。

还没有评论,来说两句吧...