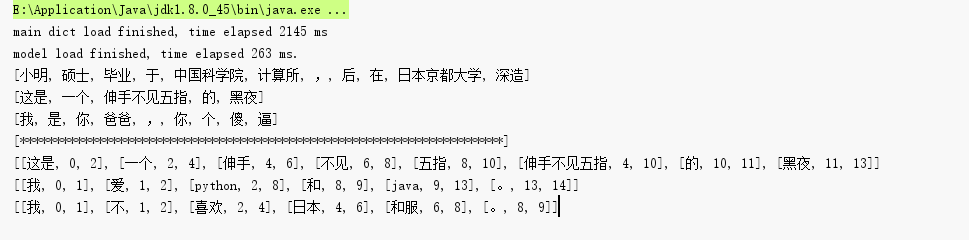

热文Python学习笔记——jieba “结巴”中文分词

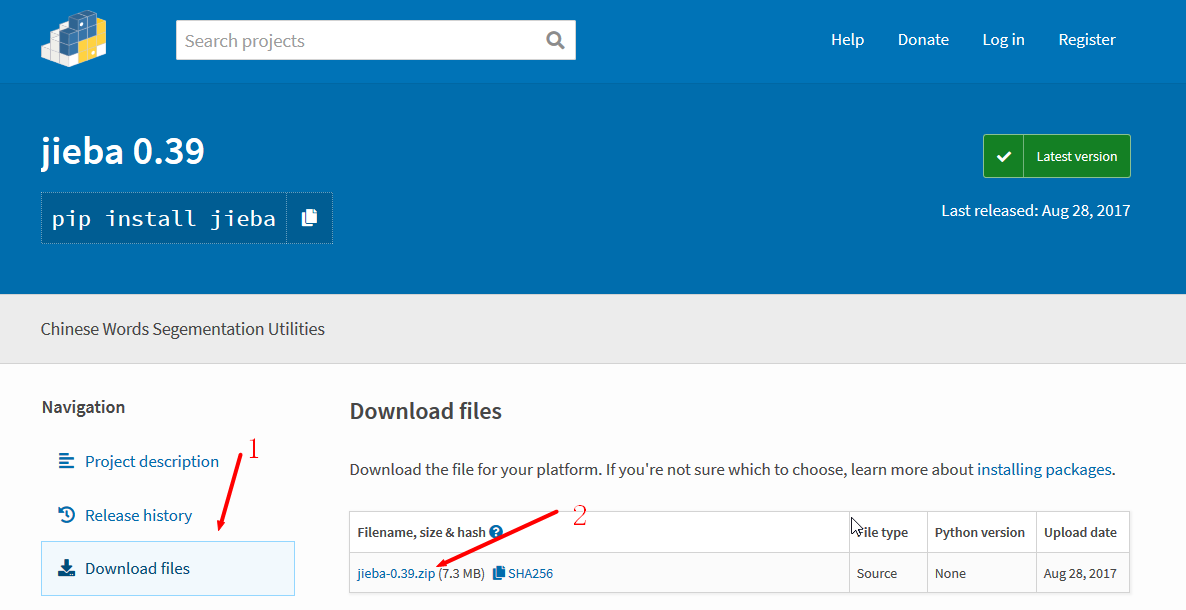

jieba 是一款号称最好用的Python中文分词组件,分词效果非常棒。支持三种分词模式,代码对 Python 2/3 均兼容,可以用于某些项目的数据预处理。 官方GitH

热文Python第三方库jieba(中文分词)入门与进阶(官方文档)

转自:[https://blog.csdn.net/qq\_34337272/article/details/79554772][https_blog.csdn.net_qq_

热文网上商城-java基础练习项目-仿照雷蛇商城

webshop java基础练习项目-仿照雷蛇商城 javaweb 基础部分,没有涉及框架,基本实现,浏览商品,查看商品,购物车,查看订单,分页显示。

热文Java计算文件MD5值

在文件上传下载相关的操作中,我们通常会遇到需要计算文件MD5的场景,计算文件MD5值的方法和计算字符串的MD5值有些类似,这里先来介绍普通的计算字符串的MD5方法。 comm

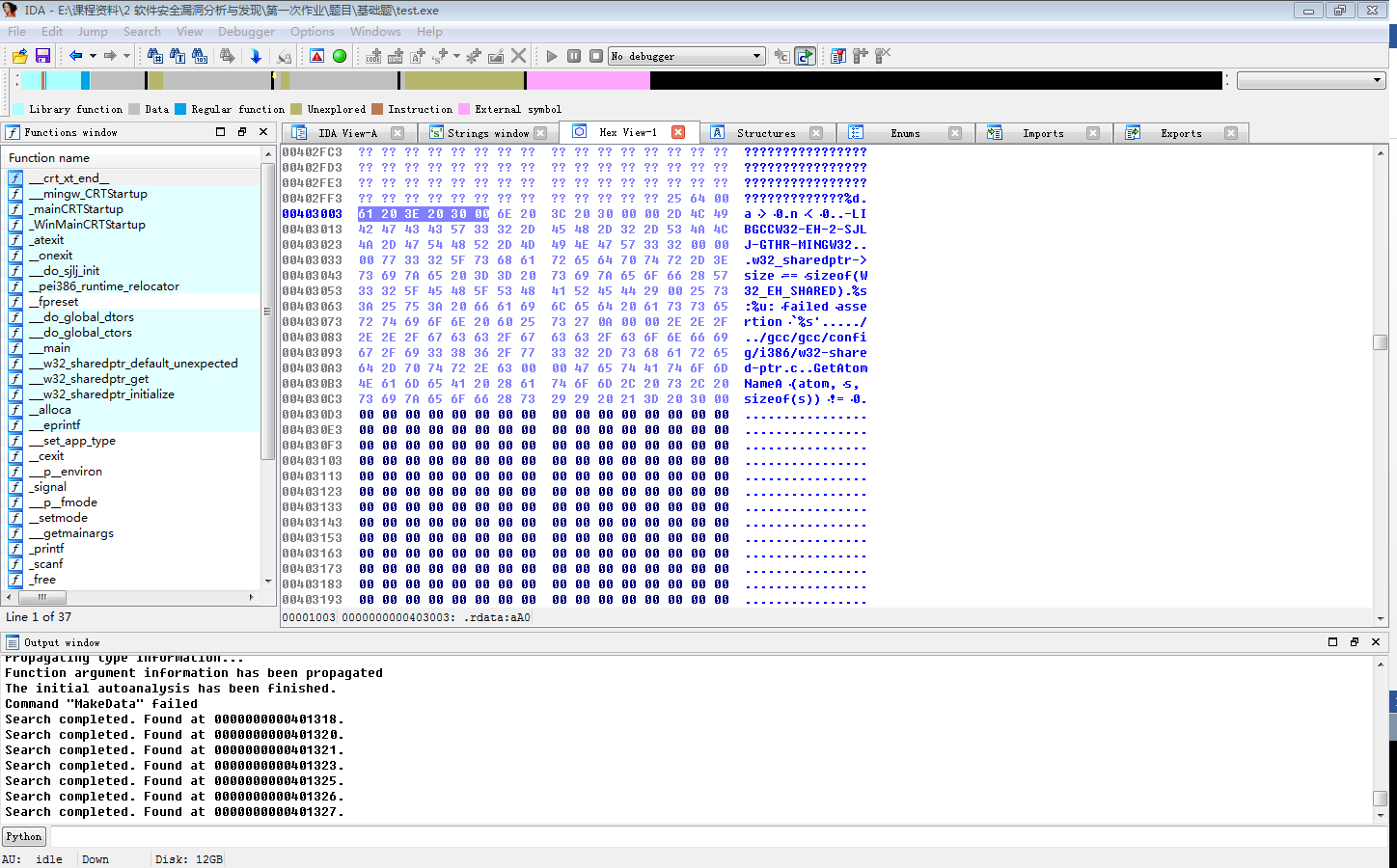

热文【转】IDA Pro 初探

IDA Pro([https://yunpan.360.cn/surl\_yFS4HRAez3H][https_yunpan.360.cn_surl_yFS4HRAez3H]

热文数字背后的欧洲足球联赛 - Transfers

这是杂货铺的第443篇文章 欧足联公布的《欧洲俱乐部全景分析报告》(英文名称:《The European Club Footballing Landscape》),

热文初探Turtlebot2

1. kobuki ros驱动安装 1)硬件连接示意图,硬件连接接口都有防误插,连接到kobuki上的如图所示,一个为[kinect][]的12V 1.5A供电接口,一个

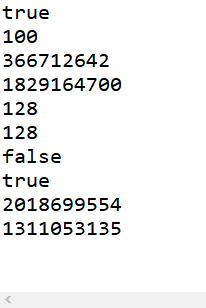

热文科普:String hashCode 方法为什么选择数字31作为乘子

> 来源:https://www.cnblogs.com/nullllun/p/8350178.html ![1240][] 一、背景 某天,我在写代码的时候,无意

热文360首席安全官谭晓生宣布离职

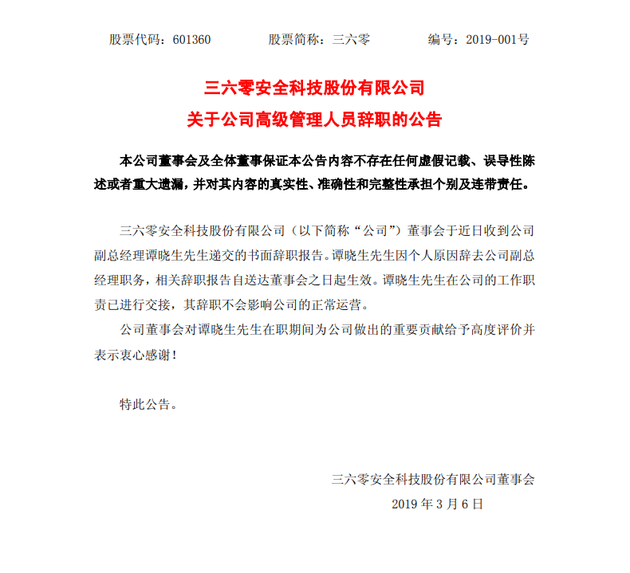

3月5日晚,360发布公告称,公司董事会于近日收到公司副总经理谭晓生先生递交的书面辞职报告。谭晓生先生因个人原因辞去公司副总经理职务,相关辞职报告自送达董事会之日起生效。谭晓生

热文solr配置IK中文分词器

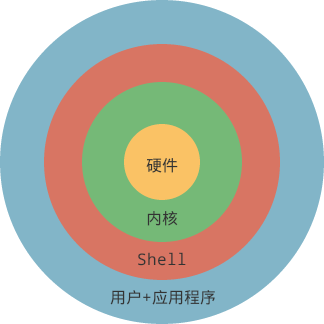

配置IK中文分词器 复制/opt/solr7/dist/solr-dataimporthandler-7.2.1.jar到/opt/tomcat9/webapps/solr/

热文对于辞职找工作的感受

日复一日,年复一年; 对于辞职,我觉得要是技术不牛的话,千万不要裸辞,因为新的技术在一天天的更新,牛的人越来越多,并且别人还努力,如果自己没有大的技术提升,基础扎实,底层原理

热文Java中hashcode的理解

如何理解hashCode的作用: ============================================================ 以java.

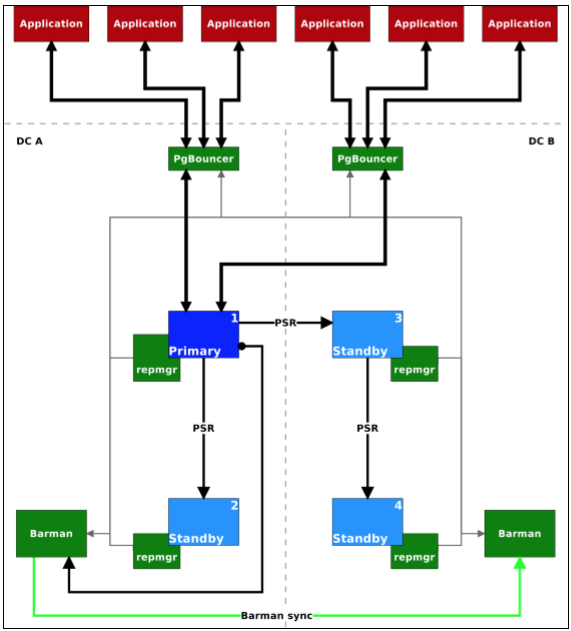

热文pgBouncer初探

pgBouncer是一个轻型的pg连接池,可以很好的管理pg的连接(对客户端连接进行限制,预防过多恶意连接;pgbouncer的每个连接仅消耗2KB的内存资源)。 PgBou

热文[CUDA] 遇到的一些让人悲喜交加的bug

1. \_\_device\_\_ 修饰的类函数,如果要在类外实现一定记得加上修饰词,否则链接的时候会出错。别问我是怎么知道的,说出来都是泪……这个bug也就让我懵逼了一整天吧

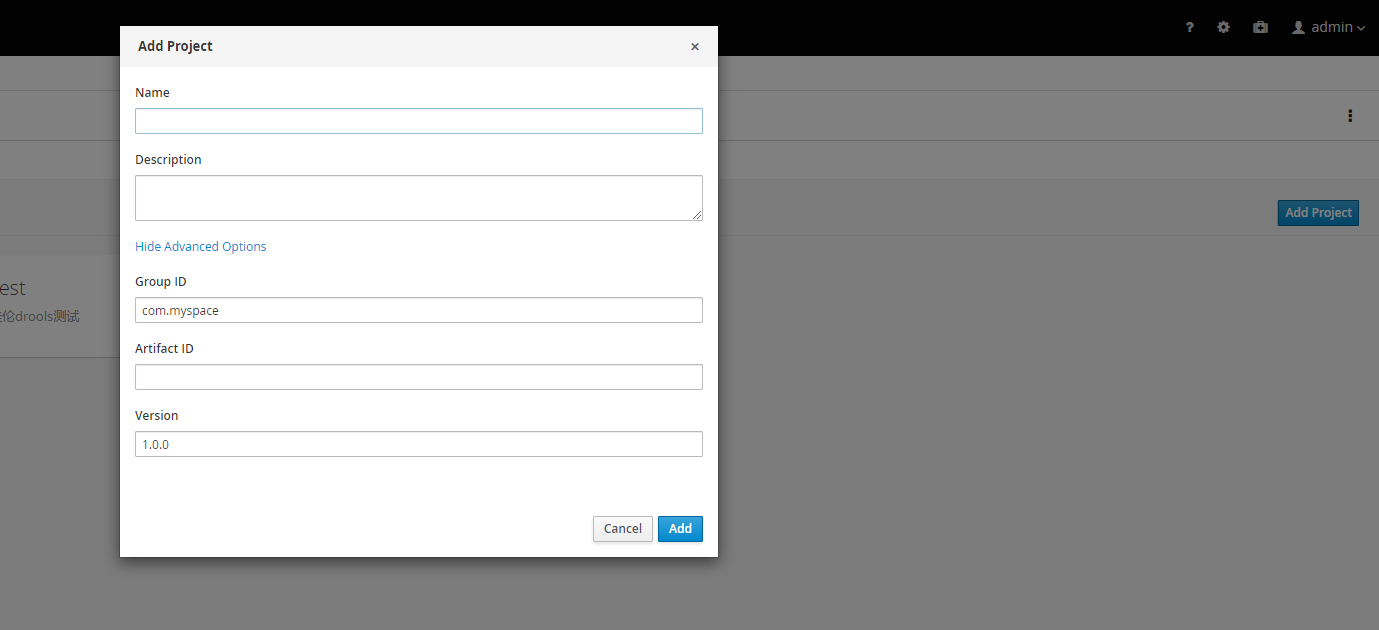

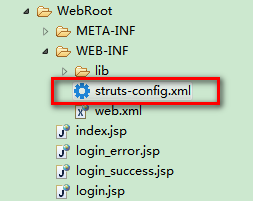

热文分步学习Struts(四) 自己写Struts框架

上次我们已经讲解分析了一下Struts原理,这次我们来自己构建一个简单的Struts框架,通过构建Struts框架来了解Struts是如何实现MVC的。 1

热文NLP相关分词和预处理工具包

jieba Python下中文分词工具 地址:[https://github.com/fxsjy/jieba][https_github.com_fxsjy_jieb

热文golang gRPC初探

gRPC使用protocol buffers作为Interface Definition Language (IDL)。 gRPC的底层信息交互格式也使用的是protoco

热文Spring Boot(06)——参数配置机制

参数配置机制 Spring Boot默认会读取Classpath根路径下的application.properties文件和application.yml文件作为配置文件

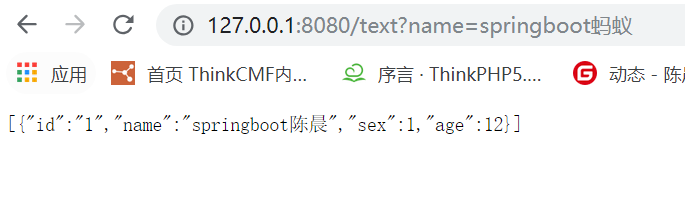

热文elasticsearch springboot 实现分词搜索

实现分词搜索之前必须保证您的springboot 已经连接上了你的elasticsearch 这里展示下我的配置信息和pom文件 application.yml

热文Python分词模块推荐:jieba中文分词

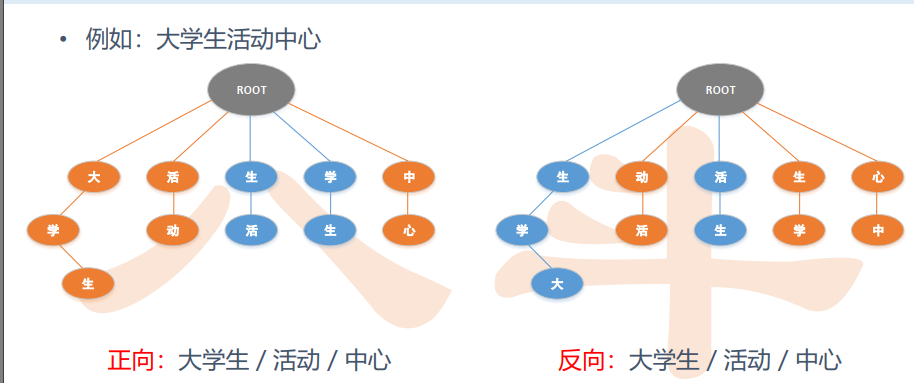

一、结巴中文分词采用的算法 基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG) 采用了动态规划查找最大概率路径,

热文结巴分词(java版) jieba-analysis

结巴分词(java版) jieba-analysis > jieba-analysis > 首先感谢jieba分词原作者fxsjy,没有他的无私贡献,我们也不会结识到