热文中断详解(五)——中断处理程序

对于异常处理来说,内核只要给引起异常的进程发送一个Unix信号就能处理大多数异常。然后内核的工作就是延迟下一个动作,知道进程接收到该信号。关于异常处理,内核并没有执行多少任务,

热文Jieba分词包(三)——基于词频最大切分组合

Jieba分词包(三)——基于词频最大切分组合 在前面,我们已经知道dict中所有的单词和词频信息已经存在了一个trie树中,并且需要分词的句子已经构建成了一个DAG图,构

热文python中文分词工具:结巴分词jieba

http://[blog.csdn.net/pipisorry/article/details/45311229][blog.csdn.net_pipisorry_articl

热文用函数fopen_s打开数据文件

学习C语言,对文件的输入和输出,打开一个数据文件,一般教材用fopen函数,但是一些编译器编译无法通过,笔者用的Vs2013,提示用fopen\_s函数代替,fopen\_s函

热文2.4.16版本Apache配置虚拟目录(1)

看了韩顺平配置Apache虚拟目录的视频教程,结果我照着里面的说法做了一下,在httpd.conf文件做如下处理: 1.把DocumentRoot 那一行注释掉,我的注释内

热文【JS】JavaScript服务器端初探

1、Rhino Rhino是Mozilla开发的免费软件,是一种用Java编写的JavaScript解释器,其设计目标是借助于强大的Java平台API实现轻松编写Java

热文如何合理的控制solr查询的命中的数量?

在solr里面,如何合理的控制的命中的数量? > 在一些日常的文章中或一些信息中,都有一些高频词,而这些高频词,在参与查询时,往往会造成,大量的结果集命中。 > 什么意思

热文Solr之中文分词

针对Solr的分词器比较多,其中最常用的的两个是mmseg4j和ik-analyzer,使用都很方便,关于分成器的比较参考:[与Lucene 4.10配合的中文分词比较][Lu

热文与Lucene 4.10配合的中文分词比较

比较目的 衡量每种分词的指标,内存消耗、CPU消耗,得到一个在Lucene中比较好的分词版本。 分词源代码介绍 paoding: 庖丁解牛最新版在 [htt

热文Lucene中文分词mmseg4j

mmseg4j 用 Chih-Hao Tsai 的[ MMSeg 算法][MMSeg]实现的中文分词器,并实现 lucene 的 analyzer 和 solr 的Tokeni

热文Lucene中文分词Paoding

Paoding中文分词库是一个使用Java开发的基于Lucene4.x的分词器,可结合到Lucene应用中的,为互联网、企业内部网使用的中文搜索引擎分词组件。Paoding填补

热文Lucene中文分词Jcseg

Jcseg是使用Java开发的一款开源的中文分词器, 基于流行的mmseg算法实现,分词准确率高达98.4%, 支持中文人名识别, 同义词匹配, 停止词过滤等。并且提供了最新版

热文Lucene中文分词IK Analyzer

IK Analyzer是一个开源的,基于java语言开发的轻量级的中文分词工具包。从2006年12月推出1.0版开始, IKAnalyzer已经推出了4个大版本。最初,它是以开

热文Lucene中文分词介绍

由于lucene自带的分词方式对中文分词十分的不友好,所以在对一段中文中的某个词组进行搜索时,需要在创建索引是对其进行分词。下面介绍一些常见的中文分词器。 一、IK Ana

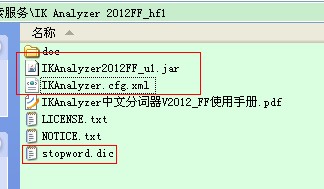

热文solr4.7中文分词器(ik-analyzer)配置

solr本身对中文分词的处理不是太好,所以中文应用很多时候都需要额外加一个中文分词器对中文进行分词处理,ik-analyzer就是其中一个不错的中文分词器。 一、版

热文(3)中文分词——Python结巴分词器

结巴分词器介绍: jieba 分词下载地址:[https://pypi.python.org/pypi/jieba][https_pypi.python.org_pypi_

热文(2)中文分词——基于词典的方法

中文分词基本算法主要分类:基于词典的方法、基于统计的方法、基于规则的方法 1、基于词典的方法(字符串匹配,机械分词方法) 定义:按照一定策略将待分析的汉字串与一个“大机

热文(1)英文分词——波特词干提取算法

英文分词相比中文分词要简单得多,可以根据空格和标点符号来分词,然后对每一个单词进行词干还原和词形还原,去掉停用词和非英文内容。词干还原算法最经典的就是波特算法(Porter A

热文Sphinx+Mysql+中文分词安装-实现中文全文搜索

参考:http://blog.csdn.net/lgm252008/article/details/5373436 1、什么是Sphinx Sphinx 是一个在G

热文搜索引擎技术揭密:中文分词技术

http://www.williamlong.info/archives/333.html 信息的飞速增长,使搜索引擎成为人们查找信息的首选工具,Google、百度、中国搜索

热文javascript中的string与其他语言string的一些不同

作者:贺师俊 链接:[https://www.zhihu.com/question/26121387/answer/32188941][https_www.zhihu.co